[LangChain] LangChain 14. LangGraph의 핵심 기능들에 대해서 알아보자

1. LangGraph 개요

LangGraph는 “상태 기반의 다중 에이전트 오케스트레이션”으로 LLM 애플리케이션에 상태 유지(Stateful) 및 순환 그래프(Cyclic Graph) 구조를 도입한 라이브러리입니다.

- Directed Acyclic Graph(DAG)의 한계를 넘어, 루프(Loop)를 허용합니다.

- State(상태) 객체를 통해 노드 간의 데이터를 공유하고 관리합니다.

- 에이전트의 행동을 세밀하게 제어(Control Flow)할 수 있어, 복잡한 커스텀 에이전트 설계에 최적화 되어 있습니다.

2. LangGraph에 자주 등장하는 Python 문법

2.1 TypedDict

TypedDict는 Python 표준 라이브러리(typing)에서 제공하는 기능으로, 딕셔너리의 키(Key)와 값(Value)의 타입을 명시적으로 지정하는 도구입니다.

LangGraph에서 TypedDict를 사용하는 이유는 LangGraph의 모든 노드(Node)는 State라고 불리는 이 TypedDict를 공유합니다.

- 데이터 일관성: 어떤 노드에서 어떤 데이터(질문, 답변, 검색 결과 등)가 오가는지 명확하게 정의합니다.

- 업데이트 규칙(Annotated): 특정 키의 값을 덮어쓸지, 혹은 기존 값에 추가(

operator.add)할지를 결정할 수 있습니다.

아래는 TypedDict 사용 예시입니다.

from typing import TypedDict

class Person(TypedDict):

name: str

age: int

job: str

typed_dict: Person = {"name": "셜리", "age": 25, "job": "디자이너"}

typed_dict["age"] = 35 # 정수형으로 올바르게 사용

typed_dict["age"] = "35" # 타입 체커가 오류를 감지함

typed_dict["new_field"] = (

"추가 정보" # 타입 체커가 정의되지 않은 키라고 오류를 발생시킴

)

2.2 Annotated

Annotated는 Python 3.9 버전부터 도입된 기능으로, 기존 타입에 부가적인 정보(Metadata)를 덧붙일 때 사용합니다.

단순히 “이 변수는 리스트야”라고 선언하는 것을 넘어, “이 리스트는 나중에 새로운 데이터가 들어오면 기존 데이터 뒤에 합쳐줘(Append)”와 같은 특별한 지시사항을 적어두는 용도라고 생각하면 쉽게 이해가 됩니다.

Annotated를 사용하는 이유는 추가 정보 제공(타입 힌트) / 문서화 때문입니다.

- 추가 정보 제공: 타입 힌트에 메타데이터를 추가하여 더 상세한 정보를 제공합니다.

- 문서화: 코드 자체에 추가 설명을 포함시켜 문서화 효과를 얻을 수 있습니다.

- 유효성 검사: 특정 라이브러리(예: Pydantic)와 함께 사용하여 데이터 유효성 검사를 수행할 수 있습니다.

- 프레임워크 지원: 일부 프레임워크(예: LangGraph)에서는

Annotated를 사용하여 특별한 동작을 정의합니다.

2.2.1 Annotated 사용 예시

from typing import Annotated, List

from pydantic import Field, BaseModel, ValidationError

class Employee(BaseModel):

id: Annotated[int, Field(..., description="직원 ID")]

name: Annotated[str, Field(..., min_length=3, max_length=50, description="이름")]

age: Annotated[int, Field(gt=18, lt=65, description="나이 (19-64세)")]

salary: Annotated[

float, Field(gt=0, lt=10000, description="연봉 (단위: 만원, 최대 10억)")

]

skills: Annotated[

List[str], Field(min_items=1, max_items=10, description="보유 기술 (1-10개)")

]

# 유효한 데이터로 인스턴스 생성

try:

valid_employee = Employee(

id=1, name="테디노트", age=30, salary=5000, skills=["Python", "LangChain"]

)

print("유효한 직원 데이터:", valid_employee)

except ValidationError as e:

print("유효성 검사 오류:", e)

# 유효하지 않은 데이터로 인스턴스 생성 시도

try:

invalid_employee = Employee(

name="테디", # 이름이 너무 짧음

age=17, # 나이가 범위를 벗어남

salary=20000, # 급여가 범위를 벗어남

skills="Python", # 리스트가 아님

)

except ValidationError as e:

print("유효성 검사 오류:")

for error in e.errors():

print(f"- {error['loc'][0]}: {error['msg']}")

Output:

유효한 직원 데이터: id=1 name='테디노트' age=30 salary=5000.0 skills=['Python', 'LangChain']

유효성 검사 오류:

- id: Field required

- name: String should have at least 3 characters

- age: Input should be greater than 18

- salary: Input should be less than 10000

- skills: Input should be a valid list

/tmp/ipython-input-1430983608.py:12: PydanticDeprecatedSince20: `min_items` is deprecated and will be removed, use `min_length` instead. Deprecated in Pydantic V2.0 to be removed in V3.0. See Pydantic V2 Migration Guide at https://errors.pydantic.dev/2.12/migration/

List[str], Field(min_items=1, max_items=10, description="보유 기술 (1-10개)")

/tmp/ipython-input-1430983608.py:12: PydanticDeprecatedSince20: `max_items` is deprecated and will be removed, use `max_length` instead. Deprecated in Pydantic V2.0 to be removed in V3.0. See Pydantic V2 Migration Guide at https://errors.pydantic.dev/2.12/migration/

List[str], Field(min_items=1, max_items=10, description="보유 기술 (1-10개)")

참고 사항으로

Annotated는 Python 3.9 이상에서 사용 가능합니다.- 런타임에는

Annotated가 무시되므로, 실제 동작에는 영향을 주지 않습니다. - 타입 검사 도구나 IDE가

Annotated를 지원해야 그 효과를 볼 수 있습니다.

2.3 add_messages

add_messages는 LangGraph에서 메시지를 리스트에 추가하는 함수입니다.

messages키는 add_messages 리듀서 함수로 주석이 달려 있으며, 이는 LangGraph에게 기존 목록에서 새 메시지를 추가하도록 지시합니다.

주석이 없는 상태 키는 각 업데이트에 의해 덮어쓰여져 가장 최근의 값이 저장됩니다.

add_messages 함수는 2개의 인자(left, right)를 받으며, 좌, 우 메시지를 병합하는 방식으로 동작합니다.

주요 기능

- 두 개의 메시지 리스트를 병합합니다.

- 기본적으로 “append-only” 상태를 유지합니다.

- 동일한 ID를 가진 메시지가 있을 경우, 새 메시지로 기존 메시지를 대체합니다.

동작 방식

right의 메시지 중left에 동일한 ID를 가진 메시지가 있으면,right의 메시지로 대체됩니다.- 그 외의 경우

right의 메시지가left에 추가됩니다.

매개 변수

left(Messages): 기본 메시지 리스트right(Messages): 병합할 메시지 리스트 또는 단일 메시지

반환 값

Messages:right의 메시지들이left에 병합된 새로운 메시지 리스트

from langchain_core.messages import AIMessage, HumanMessage

from langgraph.graph import add_messages

# 기본 사용 예시

msgs1 = [HumanMessage(content="안녕하세요?", id="1")]

msgs2 = [AIMessage(content="반갑습니다~", id="2")]

result1 = add_messages(msgs1, msgs2)

print(result1)

Output:

[HumanMessage(content='안녕하세요?', additional_kwargs={}, response_metadata={}, id='1'), AIMessage(content='반갑습니다~', additional_kwargs={}, response_metadata={}, id='2', tool_calls=[], invalid_tool_calls=[])]

동일한 ID를 가진 Message가 있을 경우 대체됩니다.

# 동일한 ID를 가진 메시지 대체 예시

msgs1 = [HumanMessage(content="안녕하세요?", id="1")]

msgs2 = [HumanMessage(content="반갑습니다~", id="1")]

result2 = add_messages(msgs1, msgs2)

print(result2)

Output:

[HumanMessage(content='반갑습니다~', additional_kwargs={}, response_metadata={}, id='1')]

3. LangGraph를 활용한 챗봇 구축

핵심 기능 익히기에는 실습 만한 것이 없다고 생각합니다. 그러므로 LangGraph를 이용한 간단한 챗봇을 구축해 보면서 LangGraph의 기본 적인 핵심 기능들에 대해서 알아가 보도록 하겠습니다.

실습 코드 실행에 앞서 코드 실행에 필요한 라이브러리 설치부터 진행해 줍니다.

!pip install langchain-openai langchain-teddynote

3.1 상태(State) 정의

from typing import Annotated, TypedDict

from langgraph.graph import StateGraph, START, END

from langgraph.graph.message import add_messages

class State(TypedDict):

# 메시지 정의(list, type이며 add_messages 함수를 사용하여 메시지를 추가)

messages: Annotated[list, add_messages]

3.2 노드(Node) 정의

chatbot 노드를 추가합니다. 노드는 작업의 단위를 나타내며, 일반적으로 정규 Python 함수입니다.

from langchain_openai import ChatOpenAI

# LLM 정의

llm = ChatOpenAI(model="gpt-4o-mini", temperature=0)

# 챗봇 함수 정의

def chatbot(state: State):

# 메시지 호출 및 반환

return {"messages": [llm.invoke(state["messages"])]}

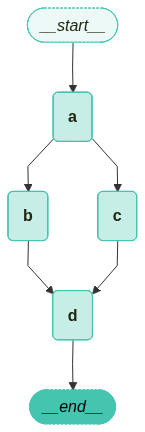

3.3 그래프(Graph) 정의, 노드 추가

-

chatbot노드 함수는 현재State를 입력으로 받아 “messages”라는 키 아래에 업데이트된messages목록을 포함하는 TypedDict를 반환합니다. -

State의add_messages함수는 이미 상태에 있는 메시지에 llm의 응답 메시지를 추가합니다.

# 그래프 생성

graph_builder = StateGraph(State)

# 노드 이름, 함수 혹은 callable 객체를 인자로 받아 노드를 추가

graph_builder.add_node("chatbot", chatbot)

3.4 그래프 엣지(Edge) 추가

# 시작 노드에서 챗봇 노드로의 엣지 추가

graph_builder.add_edge(START, "chatbot")

# 그래프에 엣지 추가

graph_builder.add_edge("chatbot", END)

3.5 그래프 컴파일

마지막으로, 그래프를 실행할 수 있어야 합니다. 이를 위해 그래프 빌더에서 compile()을 호출합니다. 이렇게 하면 상태에서 호출할 수 있는 CompiledGraph가 생성됩니다.

# 그래프 컴파일

graph = graph_builder.compile()

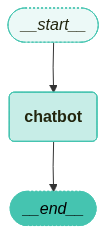

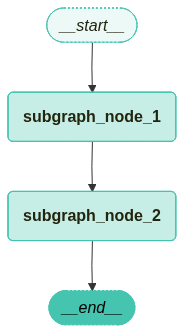

3.6 그래프 시각화

from langchain_teddynote.graphs import visualize_graph

# 그래프 시각화

visualize_graph(graph)

3.7 그래프 실행

이제 LangGraph로 정의한 챗봇을 실행해 보도록 하겠습니다.

question = "서울의 유명한 맛집 TOP 10 추천해줘"

# 그래프 이벤트 스트리밍

for event in graph.stream({"messages": [("user", question)]}):

# 이벤트 값 출력

for value in event.values():

print("Assistant:", value["messages"][-1].content)

Output:

Assistant: 서울에는 다양한 맛집이 많아서 선택하기가 쉽지 않지만, 다음은 서울에서 유명한 맛집 TOP 10을 추천해 드립니다. 각 식당은 고유의 매력을 가지고 있으니 참고해 보세요!

1. **광장시장** - 전통 시장으로, 빈대떡, 마약김밥, 떡볶이 등 다양한 길거리 음식을 즐길 수 있습니다.

2. **이태원 부대찌개** - 부대찌개로 유명한 이곳은 푸짐한 양과 깊은 맛으로 많은 사랑을 받고 있습니다.

3. **명동교자** - 칼국수와 만두가 유명한 곳으로, 항상 많은 사람들이 줄 서서 기다리는 인기 맛집입니다.

4. **삼청동 수제비** - 수제비와 전통 한식을 즐길 수 있는 아늑한 분위기의 식당입니다.

5. **한남동 고기리 막창** - 신선한 막창과 다양한 고기 요리를 제공하는 곳으로, 고기 애호가들에게 추천합니다.

6. **을지로 골뱅이** - 골뱅이 무침과 소주가 잘 어울리는 곳으로, 분위기도 좋고 맛도 뛰어납니다.

7. **홍대 돈부리** - 일본식 덮밥 전문점으로, 다양한 종류의 돈부리를 맛볼 수 있습니다.

8. **신사동 가로수길** - 다양한 카페와 레스토랑이 모여 있는 곳으로, 특히 브런치 카페가 많아 인기가 높습니다.

9. **종로 통인시장** - 전통 시장으로, 다양한 먹거리를 즐길 수 있으며, 특히 찐빵과 떡이 유명합니다.

10. **압구정 로데오거리** - 고급 레스토랑과 카페가 많은 지역으로, 다양한 세계 요리를 맛볼 수 있습니다.

각 식당은 예약이 필요할 수 있으니 방문 전에 확인해 보시는 것이 좋습니다. 맛있는 식사 되세요!

4. LangGraph를 활용한 Agent 구축

이번에는 웹 검색 도구를 통해 챗봇에 웹 검색 기능을 수행하는 Agent를 추가해 보도록 하겠습니다. LLM에 도구를 바인딩하여 LLM에 입력된 요청에 따라 필요시 웹 검색 도구(Tool)를 호출하는 Agent를 구축합니다. 뿐만 아니라, 조건부 엣지를 통해 도구 호출 여부에 따라 다른 노드로 라우팅하는 방법도 함께 배워보도록 하겠습니다.

4.1 도구 정의하기

웹 검색 도구로는 항상 사용하던 Tavily Search를 사용합니다. TavilySearchResults를 이용해 웹 검색 도구를 정의해 줍니다.

from langchain_teddynote.tools.tavily import TavilySearch

# 검색 도구 생성

tool = TavilySearch(max_results=3)

# 도구 목록에 추가

tools = [tool]

이번에는 LLM에 bind_tools로 “LLM+도구”를 구성합니다.

from typing import Annotated

from typing_extensions import TypedDict

from langgraph.graph.message import add_messages

# State 정의

class State(TypedDict):

# list 타입에 add_messages 적용

messages: Annotated[list, add_messages]

from langchain_openai import ChatOpenAI

# LLM 초기화

llm = ChatOpenAI(model="gpt-4o-mini")

# LLM에 도구 바인딩

llm_with_tools = llm.bind_tools(tools)

노드를 정의합니다.

# 노드 함수 정의

def chatbot(state: State):

answer = llm_with_tools.invoke(state["messages"])

# 메시지 목록 반환

return {"messages": [answer]}

그래프 생성 및 노드를 추가합니다.

from langgraph.graph import StateGraph

# 상태 그래프 초기화

graph_builder = StateGraph(State)

# 노드 추가

graph_builder.add_node("chatbot", chatbot)

4.2 도구 노드

이제 도구가 호출될 경우 실제로 실행할 수 있는 함수를 만들어야 합니다. 이를 위해 새로운 노드에 도구를 추가합니다. 가장 최근의 메시지를 확인하고 메시지에 tools_calls가 포함되어 있으면 도구를 호출하는 BasicToolNode 클래스를 구현합니다. 이번엔 직접 구현하지만, 나중에는 LangGraph의 pre-built 되어 있는 ToolNode로 대체할 수 있습니다.

import json

from langchain_core.messages import ToolMessage

class BasicToolNode:

"""Run tools requested in the last AIMessage node"""

def __init__(self, tools:list) -> None:

# 도구 리스트

self.tools_list = {tool.name: tool for tool in tools}

def __call__(self, inputs: dict):

if messages := inputs.get("messages", []):

message = messages[-1]

else:

raise ValueError("No message found in input")

# 도구 호출 결과

outputs = []

for tool_call in message.tool_calls:

# 도구 호출 후 결과 저장

tool_result = self.tools_list[tool_call["name"]].invoke(tool_call["args"])

outputs.append(

# 도구 호출 결과를 메시지로 저장

ToolMessage(

content=json.dumps(

tool_result, ensure_ascii=False

), # 도구 호출 결과를 문자열로 반환

name=tool_call["name"],

tool_call_id=tool_call["id"],

)

)

return {"messages": outputs}

# 도구 노드 생성

tool_node = BasicToolNode(tools = [tool])

# 그래프에 도구 노드 추가

graph_builder.add_node("tools", tool_node)

4.3 조건부 엣지

도구 노드가 추가되면 conditional_edges를 정의할 수 있습니다. Edges는 한 노드에서 다음 노드로 제어 흐름을 라우팅합니다. Conditional edges는 일반적으로 “if”문을 포함하여 현재 그래프 상태에 따라 다른 노드로 라우팅합니다. 이러한 함수는 현재 그래프 state를 받아 다음에 호출할 Node를 나타내는 문자열 또는 문자열 목록을 반환합니다.

아래 예제에서는 route_tools라는 라우터 함수를 정의하여 챗봇의 출력에서 tool_calls를 확인합니다. 이 함수는 add_conditional_edges를 호출하여 그래프에 제공하면, chatbot 노드가 완료될 때마다 이 함수를 확인하여 다음에 어디로 갈지 결정합니다. 조건은 도구 호출이 있으면 tools로 없으면 END로 라우팅됩니다.

add_conditional_edges 메서드는 시작 노드에서 여러 대상 노드로의 조건부 엣지를 추가합니다.

매개변수는 다음과 같습니다.

source(str): 시작 노드 이 노드를 나갈 때 조건부 엣지가 실행됩니다.path(Union[Callable, Runnable]): 다음 노드를 결정하는 호출 가능한 객체 또는 Runnable.path_map을 지정하지 않으면 하나 이상의 노드를 반환해야 합니다.END를 반환하면 그래프 실행이 중지됩니다.path_map(Optional[Union[dict[Hashable, str], list[str]]]): 경로와 노드 이름 간의 매핑 생략하면path가 반환하는 값이 노드 이름이어야 합니다.then(Optional[str]):path로 선택된 노드 실행 후 실행할 노드의 이름

반환값

- Self: 메서드 체이닝을 위해 자기 자신을 반환합니다.

주요 기능

- 조건부 엣지를 그래프에 추가합니다.

path_map을 딕셔너리로 변환합니다.path함수의 반환 타입을 분석하여 자동으로path_map을 생성할 수 있습니다 .- 조건부 분기를 그래프에 저장합니다.

조건부 엣지는 단일 노드에서 시작해야 하며, 이는 그래프에 chatbot 노드가 실행될 때마다 도구를 호출하면 “tools”로 이동하고, 직접 응답하면 루프를 종료하라는 의미입니다.

사전 구축된 tools_condition처럼, 함수는 도구 호출이 없을 경우 END 문자열을 반환(그래프 종료)합니다. 그래프가 END로 전환되면 더 이상 완료할 작업이 없으며 실행을 중지합니다.

from langgraph.graph import START, END

def route_tools(

state: State,):

if messages := state.get("messages", []):

# 가장 최근 AI 메시지 추출

ai_message = messages[-1]

else:

# 입력 상태에 메시지가 없는 경우 예외 발생

raise ValueError(f"No messages found in input state to tool_edge: {state}")

# AI 메시지에 도구 호출이 있는 경우 "tools" 반환

if hasattr(ai_message, "tool_calls") and len(ai_message.tool_calls) > 0:

# 도구 호출이 있는 경우 "tools" 반환

return "tools"

# 도구 호출이 없는 경우 "END" 반환

return END

# 'tools_condition' 함수는 챗봇이 도구 사용을 요청하면 "tools"를 반환하고, 직접 응답이 가능한 경우 "END"를 반환

graph_builder.add_conditional_edges(

source="chatbot",

path=route_tools,

# route_tools의 반환값이 "tools"인 경우 "tools" 노드로, 그렇지 않으면 END 노드로 라우팅

path_map={"tools": "tools", END: END},

)

# tools > chatbot

graph_builder.add_edge("tools", "chatbot")

# START > chatbot

graph_builder.add_edge(START, "chatbot")

# 그래프 컴파일

graph = graph_builder.compile()

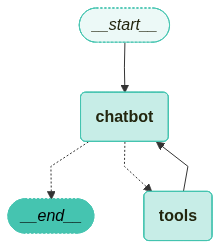

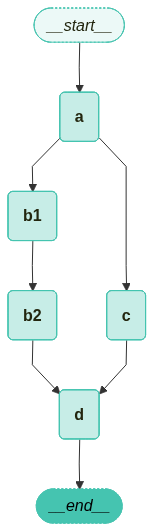

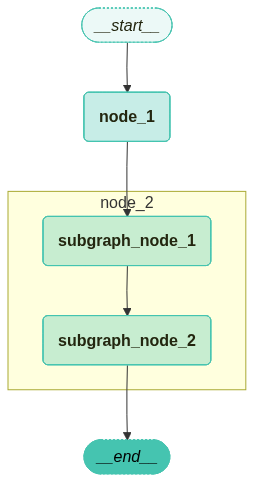

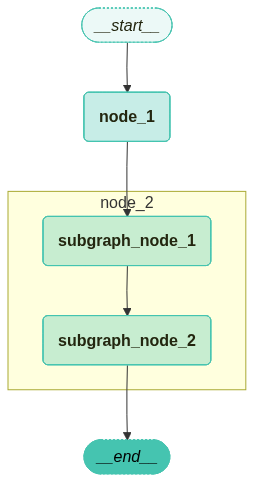

만든 그래프를 시각화 하면 다음과 같습니다.

from langchain_teddynote.graphs import visualize_graph

# 그래프 시각화

visualize_graph(graph)

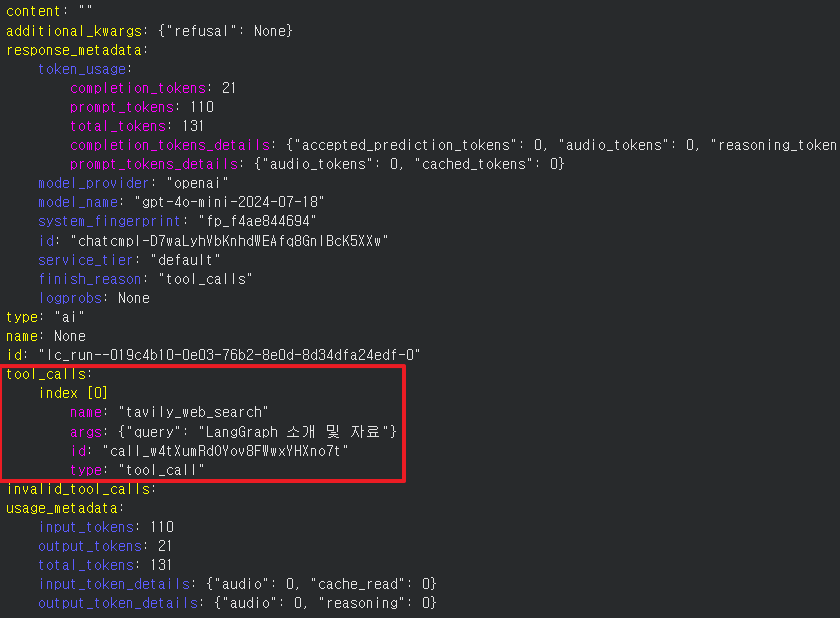

이제 챗봇에게 질문을 던지면 웹 검색을 수행한 결과를 토대로 답변을 해주게 됩니다.

from langchain_teddynote.messages import display_message_tree

question = "테디노트 YouTube"

for event in graph.stream({"messages": [("user", question)]}):

for key, value in event.items():

print(f"\n==============\nSTEP: {key}\n==============\n")

display_message_tree(value["messages"][-1])

Output:

==============

STEP: chatbot

==============

content: ""

additional_kwargs: {"refusal": None}

response_metadata:

token_usage:

completion_tokens: 22

prompt_tokens: 97

total_tokens: 119

completion_tokens_details: {"accepted_prediction_tokens": 0, "audio_tokens": 0, "reasoning_tokens": 0, "rejected_prediction_tokens": 0}

prompt_tokens_details: {"audio_tokens": 0, "cached_tokens": 0}

model_provider: "openai"

model_name: "gpt-4o-mini-2024-07-18"

system_fingerprint: "fp_6c0d1490cb"

id: "chatcmpl-D7bcq3T4SADiDn7XPJJ3P8Lx3QL9g"

service_tier: "default"

finish_reason: "tool_calls"

logprobs: None

type: "ai"

name: None

id: "lc_run--019c4642-a7e4-79a0-b034-c6b9140cf93b-0"

tool_calls:

index [0]

name: "tavily_web_search"

args: {"query": "테디노트 YouTube"}

id: "call_3C93FykeMqVTnWAT1GdfXgOO"

type: "tool_call"

invalid_tool_calls:

usage_metadata:

input_tokens: 97

output_tokens: 22

total_tokens: 119

input_token_details: {"audio": 0, "cache_read": 0}

output_token_details: {"audio": 0, "reasoning": 0}

==============

STEP: tools

==============

content: "[{"url": "https://www.youtube.com/@teddynote/streams", "title": "테디노트 TeddyNote - YouTube", "content": "### [[#langchain x 테디노트] LangChain 본사 엔지니어와 신규 출시된 LangGraph V1 신규소개 & Live Q&A + 핸즈온 합니다!](https://www.youtube.com/watch? ### [[Upstage AI x 테디노트] Document Intelligence 파헤치기 🔥](https://www.youtube.com/watch? 저자 X 테디노트] 여섯 명의 개발자가 기록한 AI 시대의 생존 전략](https://www.youtube.com/watch? ### [[빅스터 이현종 대표 X 테디노트] 생성형 AI 다음은 #판단 AI(Decisive AI)](https://www.youtube.com/watch? ### [[조우철 X 테디노트] 프로덕션을 위한 #LLM #엔지니어링 🔥](https://www.youtube.com/watch? ### [[VESSL AI X 테디노트] #Agent 시대의 Infra, Ops 그리고 #MCP 🔥](https://www.youtube.com/watch? ### [[Sionic AI 박진형, 김혜원 X 테디노트] 엔터프라이즈 환경의 AI #Agent & #RAG 도입 끝장내기 🔥](https://www.youtube.com/watch? ### [[전현준 X 테디노트] \"MCP, A2A\" 진짜 엔터프라이즈 적용할 수 있을지 집중탐구 + #바이브코딩 🔥](https://www.youtube.com/watch? ### [[OneLineAI 손규진 X 테디노트] 비전공자에서 AI 연구원이 되기까지, Reasoning Model 이 열어줄 새로운 가능성 🔥](https://www.youtube.com/watch? ### [[모두의AI 케인 X 테디노트] 큰 그림으로 살펴보는 AI 산업 동향 (feat.팔란티어 온톨로지) 🔥](https://www.youtube.com/watch? ### [[KAIST, MARKR.AI 이승유 X 테디노트] Reasoning 모델 & Test Time Scaling 심층탐구🔥](https://www.youtube.com/watch? ### [[GraphRAG 정이태 X 테디노트] GraphRAG, 실무에 적용하기 위한 고려요소 심층탐구 🔥](https://www.youtube.com/watch? ### [[KAIST 장동인 교수 X 테디노트] AI 시대, 개발자의 미래](https://www.youtube.com/watch?", "score": 0.8585411, "raw_content": "테디노트 TeddyNote - YouTube\n===============\n\n Back [](https://www.youtube.com/ \"YouTube Home\")\n\nSkip navigation\n\n Search \n\n Search with your voice \n\n[](https://www.youtube.com/@teddynote/streams)\n\n[Sign in](https://accounts.google.com/ServiceLogin?service=youtube&uilel=3&passive=true&continue=https%3A%2F%2Fwww.youtube.com%2Fsignin%3Faction_handle_signin%3Dtrue%26app%3Ddesktop%26hl%3Den%26next%3Dhttps%253A%252F%252Fwww.youtube.com%252F%2540teddynote%252Fstreams&hl=en&ec=65620)\n\n[](https://www.youtube.com/ \"YouTube Home\")\n\n[Home Home](https://www.youtube.com/ \"Home\")[Shorts Shorts](https://www.youtube.com/shorts/ \"Shorts\")[Subscriptions Subscriptions](https://www.youtube.com/feed/subscriptions \"Subscriptions\")[You You](https://www.youtube.com/feed/you \"You\")\n\n\n\n\n\n테디노트 TeddyNote\n==============\n\n@teddynote\n\n•\n\n50.2K subscribers•285 videos\n\n데이터 분석, 머신러닝, 딥러닝, LLM 에 대한 내용을 다룹니다. 연구보다는 개발에 관심이 많습니다 🙇♂️ ...more 데이터 분석, 머신러닝, 딥러닝, LLM 에 대한 내용을 다룹니다. 연구보다는 개발에 관심이 많습니다 🙇♂️ ...more...more[fastcampus.co.kr/data_online_teddy](https://www.youtube.com/redirect?event=channel_header&redir_token=QUFFLUhqazBXUDk4Mk9jUHdvN2w3UVhscmpSWHNZeHJad3xBQ3Jtc0ttUTM4Qy15R3JXT2RrLVdfY2R3SjRUTm94N3Npd3JUQk9TS1lYM3hjVkkzUG10WkFRdzJqT2FNd19KanN1bEMtSGhBWnl2V0twZW1LUU1pTkFYQkE4eDV3NGNSemZ1WDkwb2tGMjFIZTIwcWl6RUhoSQ&q=https%3A%2F%2Ffastcampus.co.kr%2Fdata_online_teddy)[and 2 more links](javascript:void(0);)\n\nSubscribe\n\nJoin\n\nHome\n\nVideos\n\nShorts\n\nLive\n\nPlaylists\n\nPosts\n\nSearch \n\n Previous \n\nLatest\n\nPopular\n\nOldest\n\n Next \n\n[ 1:54:41 1:54:41 Now playing](https://www.youtube.com/watch?v=SKqCA-43nPM)[1:54:41 1:54:41 1:54:41 Now playing](https://www.youtube.com/watch?v=SKqCA-43nPM)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[전현준 x 테디노트] #Context Engineering 을 위한 #DeepAgents 와 #Agentic Coding(Claude Code)](https://www.youtube.com/watch?v=SKqCA-43nPM \"[전현준 x 테디노트] #Context Engineering 을 위한 #DeepAgents 와 #Agentic Coding(Claude Code)\")\n\n•\n\n•\n\n3.9K views Streamed 2 weeks ago\n\n[ 3:46:55 3:46:55 Now playing](https://www.youtube.com/watch?v=QAMDYNaDegM)[3:46:55 3:46:55 3:46:55 Now playing](https://www.youtube.com/watch?v=QAMDYNaDegM)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[#langchain x 테디노트] LangChain 본사 엔지니어와 신규 출시된 LangGraph V1 신규소개 & Live Q&A + 핸즈온 합니다!](https://www.youtube.com/watch?v=QAMDYNaDegM \"[#langchain x 테디노트] LangChain 본사 엔지니어와 신규 출시된 LangGraph V1 신규소개 & Live Q&A + 핸즈온 합니다!\")\n\n•\n\n•\n\n2.4K views Streamed 1 month ago\n\n[ 2:48:16 2:48:16 Now playing](https://www.youtube.com/watch?v=BSSzgEtIUp0)[2:48:16 2:48:16 2:48:16 Now playing](https://www.youtube.com/watch?v=BSSzgEtIUp0)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[Upstage AI x 테디노트] Document Intelligence 파헤치기 🔥](https://www.youtube.com/watch?v=BSSzgEtIUp0 \"[Upstage AI x 테디노트] Document Intelligence 파헤치기 🔥\")\n\n•\n\n•\n\n2.8K views Streamed 1 month ago\n\n[ 2:19:25 2:19:25 Now playing](https://www.youtube.com/watch?v=qq8HxJxy7gE)[2:19:25 2:19:25 2:19:25 Now playing](https://www.youtube.com/watch?v=qq8HxJxy7gE)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[DocentPro x 테디노트] 실리콘밸리 AI Travel 대표와 함께하는 커리어 & 개발 관련 무물(AMA)!](https://www.youtube.com/watch?v=qq8HxJxy7gE \"[DocentPro x 테디노트] 실리콘밸리 AI Travel 대표와 함께하는 커리어 & 개발 관련 무물(AMA)!\")\n\n•\n\n•\n\n1.2K views Streamed 2 months ago\n\n[ 2:17:15 2:17:15 Now playing](https://www.youtube.com/watch?v=wDUl7KjV7KI)[2:17:15 2:17:15 2:17:15 Now playing](https://www.youtube.com/watch?v=wDUl7KjV7KI)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[AI 개발자가 되고 싶으세요? 저자 X 테디노트] 여섯 명의 개발자가 기록한 AI 시대의 생존 전략](https://www.youtube.com/watch?v=wDUl7KjV7KI \"[AI 개발자가 되고 싶으세요? 저자 X 테디노트] 여섯 명의 개발자가 기록한 AI 시대의 생존 전략\")\n\n•\n\n•\n\n3.3K views Streamed 2 months ago\n\n[ 3:12:00 3:12:00 Now playing](https://www.youtube.com/watch?v=eQfhOfmbJJI)[3:12:00 3:12:00 3:12:00 Now playing](https://www.youtube.com/watch?v=eQfhOfmbJJI)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[빅스터 이현종 대표 X 테디노트] 생성형 AI 다음은 #판단 AI(Decisive AI)](https://www.youtube.com/watch?v=eQfhOfmbJJI \"[빅스터 이현종 대표 X 테디노트] 생성형 AI 다음은 #판단 AI(Decisive AI)\")\n\n•\n\n•\n\n2.5K views Streamed 3 months ago\n\n[ 2:03:06 2:03:06 Now playing](https://www.youtube.com/watch?v=VpIBx1CzEdQ&pp=0gcJCZEKAYcqIYzv)[2:03:06 2:03:06 2:03:06 Now playing](https://www.youtube.com/watch?v=VpIBx1CzEdQ&pp=0gcJCZEKAYcqIYzv)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[이승유 X 테디노트] 2025 ICLR, NeurIPS 페이퍼 리뷰 및 LLM Calibration](https://www.youtube.com/watch?v=VpIBx1CzEdQ&pp=0gcJCZEKAYcqIYzv \"[이승유 X 테디노트] 2025 ICLR, NeurIPS 페이퍼 리뷰 및 LLM Calibration\")\n\n•\n\n•\n\n1.6K views Streamed 3 months ago\n\n[ 2:32:41 2:32:41 Now playing](https://www.youtube.com/watch?v=793bvM1Mrtg)[2:32:41 2:32:41 2:32:41 Now playing](https://www.youtube.com/watch?v=793bvM1Mrtg)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[정이태 X 테디노트] 과연 #온톨로지 가 #GraphRAG 에 도움이 될까? 👀](https://www.youtube.com/watch?v=793bvM1Mrtg \"[정이태 X 테디노트] 과연 #온톨로지 가 #GraphRAG 에 도움이 될까? 👀\")\n\n•\n\n•\n\n5.6K views Streamed 5 months ago\n\n[ 2:19:35 2:19:35 Now playing](https://www.youtube.com/watch?v=g2QjywBXODk)[2:19:35 2:19:35 2:19:35 Now playing](https://www.youtube.com/watch?v=g2QjywBXODk)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[조우철 X 테디노트] 프로덕션을 위한 #LLM #엔지니어링 🔥](https://www.youtube.com/watch?v=g2QjywBXODk \"[조우철 X 테디노트] 프로덕션을 위한 #LLM #엔지니어링 🔥\")\n\n•\n\n•\n\n2.5K views Streamed 5 months ago\n\n[ 2:10:40 2:10:40 Now playing](https://www.youtube.com/watch?v=tqOkjsVzoSo)[2:10:40 2:10:40 2:10:40 Now playing](https://www.youtube.com/watch?v=tqOkjsVzoSo)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[강병진 X 테디노트] #AI 를 회사에서 언제 어떻게 활용하면 좋을까? 🔥](https://www.youtube.com/watch?v=tqOkjsVzoSo \"[강병진 X 테디노트] #AI 를 회사에서 언제 어떻게 활용하면 좋을까? 🔥\")\n\n•\n\n•\n\n5.2K views Streamed 5 months ago\n\n[ 2:04:20 2:04:20 Now playing](https://www.youtube.com/watch?v=-7jZoe__kBE)[2:04:20 2:04:20 2:04:20 Now playing](https://www.youtube.com/watch?v=-7jZoe__kBE)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[Sionic AI 박진형, 김혜원 X 테디노트] 엔터프라이즈 환경의 AI #Agent & #RAG 도입 끝장내기 🔥](https://www.youtube.com/watch?v=-7jZoe__kBE \"[Sionic AI 박진형, 김혜원 X 테디노트] 엔터프라이즈 환경의 AI #Agent & #RAG 도입 끝장내기 🔥\")\n\n•\n\n•\n\n4.3K views Streamed 6 months ago\n\n[ 2:52:15 2:52:15 Now playing](https://www.youtube.com/watch?v=WIqo3Fmxjqk)[2:52:15 2:52:15 2:52:15 Now playing](https://www.youtube.com/watch?v=WIqo3Fmxjqk)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[배휘동,임동준 X 테디노트] \"바이브 코딩을 하는 것과 잘 하는 것, 점점 더 잘 하는 것은 다릅니다\" #바이브코딩 🔥](https://www.youtube.com/watch?v=WIqo3Fmxjqk \"[배휘동,임동준 X 테디노트] \\\"바이브 코딩을 하는 것과 잘 하는 것, 점점 더 잘 하는 것은 다릅니다\\\" #바이브코딩 🔥\")\n\n•\n\n•\n\n6.8K views Streamed 6 months ago\n\n[ 2:53:01 2:53:01 Now playing](https://www.youtube.com/watch?v=z2rnK9COhuQ)[2:53:01 2:53:01 2:53:01 Now playing](https://www.youtube.com/watch?v=z2rnK9COhuQ)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[전현준 X 테디노트] \"MCP, A2A\" 진짜 엔터프라이즈 적용할 수 있을지 집중탐구 + #바이브코딩 🔥](https://www.youtube.com/watch?v=z2rnK9COhuQ \"[전현준 X 테디노트] \\\"MCP, A2A\\\" 진짜 엔터프라이즈 적용할 수 있을지 집중탐구 + #바이브코딩 🔥\")\n\n•\n\n•\n\n5.4K views Streamed 7 months ago\n\n[ 2:15:40 2:15:40 Now playing](https://www.youtube.com/watch?v=YShTiM-_ygU)[2:15:40 2:15:40 2:15:40 Now playing](https://www.youtube.com/watch?v=YShTiM-_ygU)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[Github Klaire 님 X 테디노트] 실리콘밸리 개발자 문화, 주니어 개발자를 위한 조언 🔥](https://www.youtube.com/watch?v=YShTiM-_ygU \"[Github Klaire 님 X 테디노트] 실리콘밸리 개발자 문화, 주니어 개발자를 위한 조언 🔥\")\n\n•\n\n•\n\n2.5K views Streamed 7 months ago\n\n[ 2:29:16 2:29:16 Now playing](https://www.youtube.com/watch?v=po0Li4cDlEc)[2:29:16 2:29:16 2:29:16 Now playing](https://www.youtube.com/watch?v=po0Li4cDlEc)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[OneLineAI 손규진 X 테디노트] 비전공자에서 AI 연구원이 되기까지, Reasoning Model 이 열어줄 새로운 가능성 🔥](https://www.youtube.com/watch?v=po0Li4cDlEc \"[OneLineAI 손규진 X 테디노트] 비전공자에서 AI 연구원이 되기까지, Reasoning Model 이 열어줄 새로운 가능성 🔥\")\n\n•\n\n•\n\n3.4K views Streamed 8 months ago\n\n[ 56:23 56:23 Now playing](https://www.youtube.com/watch?v=ZjjSqfv1Ypk)[56:23 56:23 56:23 Now playing](https://www.youtube.com/watch?v=ZjjSqfv1Ypk)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [LangChain Interrupt 샌프란시스코 마지막날 뒷풀이 토크 (w/ 랭체인 오픈튜토리얼 팀)](https://www.youtube.com/watch?v=ZjjSqfv1Ypk \"LangChain Interrupt 샌프란시스코 마지막날 뒷풀이 토크 (w/ 랭체인 오픈튜토리얼 팀)\")\n\n•\n\n•\n\n1.8K views Streamed 8 months ago\n\n[ 3:46:25 3:46:25 Now playing](https://www.youtube.com/watch?v=2eKd4UbSXy0)[3:46:25 3:46:25 3:46:25 Now playing](https://www.youtube.com/watch?v=2eKd4UbSXy0)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[모두의AI 케인 X 테디노트] 큰 그림으로 살펴보는 AI 산업 동향 (feat.팔란티어 온톨로지) 🔥](https://www.youtube.com/watch?v=2eKd4UbSXy0 \"[모두의AI 케인 X 테디노트] 큰 그림으로 살펴보는 AI 산업 동향 (feat.팔란티어 온톨로지) 🔥\")\n\n•\n\n•\n\n7K views Streamed 8 months ago\n\n[ 2:46:00 2:46:00 Now playing](https://www.youtube.com/watch?v=YcfM6maLiWo&pp=0gcJCZEKAYcqIYzv)[2:46:00 2:46:00 2:46:00 Now playing](https://www.youtube.com/watch?v=YcfM6maLiWo&pp=0gcJCZEKAYcqIYzv)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[VESSL AI X 테디노트] #Agent 시대의 Infra, Ops 그리고 #MCP 🔥](https://www.youtube.com/watch?v=YcfM6maLiWo&pp=0gcJCZEKAYcqIYzv \"[VESSL AI X 테디노트] #Agent 시대의 Infra, Ops 그리고 #MCP 🔥\")\n\n•\n\n•\n\n3.4K views Streamed 9 months ago\n\n[ 2:34:36 2:34:36 Now playing](https://www.youtube.com/watch?v=eKsrya-v-04)[2:34:36 2:34:36 2:34:36 Now playing](https://www.youtube.com/watch?v=eKsrya-v-04)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[벨루가 X 테디노트] 벨루가 멀티 RAG 아키텍처: LangGraph 활용 파이프라인🔥](https://www.youtube.com/watch?v=eKsrya-v-04 \"[벨루가 X 테디노트] 벨루가 멀티 RAG 아키텍처: LangGraph 활용 파이프라인🔥\")\n\n•\n\n•\n\n2.4K views Streamed 9 months ago\n\n[ 2:38:15 2:38:15 Now playing](https://www.youtube.com/watch?v=VsCU6jTffec)[2:38:15 2:38:15 2:38:15 Now playing](https://www.youtube.com/watch?v=VsCU6jTffec)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[KAIST, MARKR.AI 이승유 X 테디노트] Reasoning 모델 & Test Time Scaling 심층탐구🔥](https://www.youtube.com/watch?v=VsCU6jTffec \"[KAIST, MARKR.AI 이승유 X 테디노트] Reasoning 모델 & Test Time Scaling 심층탐구🔥\")\n\n•\n\n•\n\n2.9K views Streamed 9 months ago\n\n[ 3:00:16 3:00:16 Now playing](https://www.youtube.com/watch?v=zHN2jDZHvI0)[3:00:16 3:00:16 3:00:16 Now playing](https://www.youtube.com/watch?v=zHN2jDZHvI0)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[GraphRAG 정이태 X 테디노트] GraphRAG, 실무에 적용하기 위한 고려요소 심층탐구 🔥](https://www.youtube.com/watch?v=zHN2jDZHvI0 \"[GraphRAG 정이태 X 테디노트] GraphRAG, 실무에 적용하기 위한 고려요소 심층탐구 🔥\")\n\n•\n\n•\n\n7.6K views Streamed 10 months ago\n\n[ 2:43:55 2:43:55 Now playing](https://www.youtube.com/watch?v=0vFV3GRUbSM)[2:43:55 2:43:55 2:43:55 Now playing](https://www.youtube.com/watch?v=0vFV3GRUbSM)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[양파 X 테디노트] 생성형 AI 로 RAG 시스템 만드는 실무자에게 Ask Me Anything! \"진로 상담 환영\"](https://www.youtube.com/watch?v=0vFV3GRUbSM \"[양파 X 테디노트] 생성형 AI 로 RAG 시스템 만드는 실무자에게 Ask Me Anything! \\\"진로 상담 환영\\\"\")\n\n•\n\n•\n\n3.7K views Streamed 10 months ago\n\n[ 2:24:11 2:24:11 Now playing](https://www.youtube.com/watch?v=UaJ7_kloQUQ)[2:24:11 2:24:11 2:24:11 Now playing](https://www.youtube.com/watch?v=UaJ7_kloQUQ)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[문라이트 X 테디노트] 논문, 너도 읽을 수 있어! – 연구의 장벽을 낮추는 #Moonlight](https://www.youtube.com/watch?v=UaJ7_kloQUQ \"[문라이트 X 테디노트] 논문, 너도 읽을 수 있어! – 연구의 장벽을 낮추는 #Moonlight\")\n\n•\n\n•\n\n5.3K views Streamed 10 months ago\n\n[ 3:07:40 3:07:40 Now playing](https://www.youtube.com/watch?v=Z-ELkZ_azYM)[3:07:40 3:07:40 3:07:40 Now playing](https://www.youtube.com/watch?v=Z-ELkZ_azYM)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[노토랩 변형호 X 테디노트] LLM의 새로운 전환점, Reasoning 모델 이해하기 (Feat. DeepSeek R1)](https://www.youtube.com/watch?v=Z-ELkZ_azYM \"[노토랩 변형호 X 테디노트] LLM의 새로운 전환점, Reasoning 모델 이해하기 (Feat. DeepSeek R1)\")\n\n•\n\n•\n\n5.7K views Streamed 11 months ago\n\n[ 2:40:50 2:40:50 Now playing](https://www.youtube.com/watch?v=4cFEWqlALdo)[2:40:50 2:40:50 2:40:50 Now playing](https://www.youtube.com/watch?v=4cFEWqlALdo)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[KAIST 장동인 교수 X 테디노트] AI 시대, 개발자의 미래](https://www.youtube.com/watch?v=4cFEWqlALdo \"[KAIST 장동인 교수 X 테디노트] AI 시대, 개발자의 미래\")\n\n•\n\n•\n\n4.1K views Streamed 11 months ago\n\n[ 2:26:40 2:26:40 Now playing](https://www.youtube.com/watch?v=SVIxfMueeiE)[2:26:40 2:26:40 2:26:40 Now playing](https://www.youtube.com/watch?v=SVIxfMueeiE)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[엄마표AI코딩 이호정 X 테디노트] 지금은 어떤 AI를 써 볼까? 나의 생산성을 높여줄 모든 AI](https://www.youtube.com/watch?v=SVIxfMueeiE \"[엄마표AI코딩 이호정 X 테디노트] 지금은 어떤 AI를 써 볼까? 나의 생산성을 높여줄 모든 AI\")\n\n•\n\n•\n\n2.3K views Streamed 11 months ago\n\n[ 3:23:21 3:23:21 Now playing](https://www.youtube.com/watch?v=PKaSOnYLiHg)[3:23:21 3:23:21 3:23:21 Now playing](https://www.youtube.com/watch?v=PKaSOnYLiHg)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[전현준, 손규진 X 테디노트] 실무자가 말하는 #sLM & #LangGraph 활용](https://www.youtube.com/watch?v=PKaSOnYLiHg \"[전현준, 손규진 X 테디노트] 실무자가 말하는 #sLM & #LangGraph 활용\")\n\n•\n\n•\n\n5.2K views Streamed 1 year ago\n\n[ 2:12:16 2:12:16 Now playing](https://www.youtube.com/watch?v=7m5Xzfd95hw&pp=0gcJCZEKAYcqIYzv)[2:12:16 2:12:16 2:12:16 Now playing](https://www.youtube.com/watch?v=7m5Xzfd95hw&pp=0gcJCZEKAYcqIYzv)\n\n[](https://www.youtube.com/@teddynote/streams \"undefined\")\n\n### [[AIFactory 김태영 대표 X 테디노트] 어시웍스 - 생성형AI부터 에이전틱AI까지 비개발자도 뚝딱 🤖](https://www.youtube.com/watch?v=7m5Xzfd95hw&pp=0gcJCZEKAYcqIYzv \"[AIFactory 김태영 대표 X 테디노트] 어시웍스 - 생성형AI부터 에이전틱AI까지 비개발자도 뚝딱 🤖\")\n\n•\n\n•\n\n2.8K views Streamed 1 year ago\n\n\n\n[](https://www.youtube.com/@teddynote/streams)\n\n[](https://www.youtube.com/@teddynote/streams)\n\n[](https://www.youtube.com/@teddynote/streams)\n\n[](https://www.youtube.com/@teddynote/streams)\n\n[](https://www.youtube.com/@teddynote/streams)\n\n[](https://www.youtube.com/@teddynote/streams)\n\nTap to unmute\n\n2x\n\n[](https://www.youtube.com/@teddynote/streams)\n\n[](https://www.youtube.com/@teddynote/streams)\n\nSearch\n\nInfo\n\nShopping\n\n\n\n[](https://www.youtube.com/@teddynote/streams)\n\nIf playback doesn't begin shortly, try restarting your device.\n\n•\n\nYou're signed out\n\nVideos you watch may be added to the TV's watch history and influence TV recommendations. To avoid this, cancel and sign in to YouTube on your computer.\n\nCancel Confirm\n\n[](https://www.youtube.com/@teddynote/streams)\n\nShare\n\n[](https://www.youtube.com/@teddynote/streams \"Share link\")- [x] Include playlist \n\nAn error occurred while retrieving sharing information. Please try again later.\n\nWatch later\n\nShare\n\nCopy link\n\n\n\n0:00\n\n[](https://www.youtube.com/@teddynote/streams)[](https://www.youtube.com/@teddynote/streams \"Next (SHIFT+n)\")\n\n / \n\nLive\n\n•Watch full video\n\n•\n\n•\n\n[](https://www.youtube.com/@teddynote/streams)\n\n[](https://www.youtube.com/@teddynote/streams)\n\nNaN / NaN\n\n[[](https://www.youtube.com/@teddynote/streams)](https://www.youtube.com/@teddynote/streams)"}, {"url": "https://www.youtube.com/channel/UCt2wAAXgm87ACiQnDHQEW6Q", "title": "테디노트 TeddyNote - YouTube", "content": "TermsPrivacyPolicy & SafetyHow YouTube worksTest new featuresNFL Sunday Ticket. #RAG 의 동작 과정 쉽게 이해하기! Videos you watch may be added to the TV's watch history and influence TV recommendations. To avoid this, cancel and sign in to YouTube on your computer. Easily understand the operation process of #RAG! \\*This video is an edited version of the \"RAG Secret Notes\" lecture, available on [Fast Campus]. ⭐️ Fast Campus RAG Secret Notes [20% Discount Event] ⭐️. 🔆 Discount Code: Teddy Note RAG. ✅ Course Link: https://buly.kr/90aYONY. 📘 Langchain Tutorial Free Ebook (wikidocs). https://wikidocs.net/book/14314. ✅ Langchain Korean Tutorial Code Repository (GitHub). https://github.com/teddylee777/langch... 📍 \"Teddy Note's RAG Secret Notes\" Langchain Lecture: https://fastcampus.co.kr/data\\_online\\_... 📝 Teddy Note (GitHub Blog): https://teddylee777.github.io. ## Videos. ### Introducing Deep Agent Builder, an agent builder built with natural language. ### LangSmith Agent Builder, the first #no-code agent builder by #langchain. ### Exploring the Possibilities of #MCP X #A2A Enterprise-Oriented Security Design Architecture. ### 🔥How to make RAG into #MCP (claude desktop, cursor)🔥🔥\").", "score": 0.83452857, "raw_content": "Back\n\n[About](https://www.youtube.com/about/)[Press](https://www.youtube.com/about/press/)[Copyright](https://www.youtube.com/about/copyright/)[Contact us](/t/contact_us/)[Creators](https://www.youtube.com/creators/)[Advertise](https://www.youtube.com/ads/)[Developers](https://developers.google.com/youtube)\n\n[Terms](/t/terms)[Privacy](/t/privacy)[Policy & Safety](https://www.youtube.com/about/policies/)[How YouTube works](https://www.youtube.com/howyoutubeworks?utm_campaign=ytgen&utm_source=ythp&utm_medium=LeftNav&utm_content=txt&u=https%3A%2F%2Fwww.youtube.com%2Fhowyoutubeworks%3Futm_source%3Dythp%26utm_medium%3DLeftNav%26utm_campaign%3Dytgen)[Test new features](/new)[NFL Sunday Ticket](https://tv.youtube.com/learn/nflsundayticket)\n\n© 2026 Google LLC\n\n\n\n\n\n\n\n\n\n\n\n\n\n\n\n\n\n[EP01. #RAG 의 동작 과정 쉽게 이해하기!](https://www.youtube.com/watch?v=zybyszetEcE)\n\n2x\n\n[Includes paid promotion](https://support.google.com/youtube?p=ppp&nohelpkit=1)\n\nIf playback doesn't begin shortly, try restarting your device.\n\n•\n\nYou're signed out\n\nVideos you watch may be added to the TV's watch history and influence TV recommendations. To avoid this, cancel and sign in to YouTube on your computer.\n\nCancelConfirm\n\n테디노트 TeddyNote\n\nSubscribe\n\nUnsubscribe\n\nShare\n\nAn error occurred while retrieving sharing information. Please try again later.\n\nWatch later\n\nShare\n\nCopy link\n\n0:00\n\n0:00 / 23:58\n\nLive\n\n•Watch full video\n\n•\n\n•\n\n[EP01. Easily understand the operation process of #RAG!](/watch?v=zybyszetEcE)\n\n\n•\n\n•\n\n81,590 views\n1 year ago\n\n\\*This video is an edited version of the \"RAG Secret Notes\" lecture, available on [Fast Campus].\nA more detailed lecture curriculum can be found at the link below.\n⭐️ Fast Campus RAG Secret Notes [20% Discount Event] ⭐️\n🔆 Discount Code: Teddy Note RAG\n✅ Course Link: [https://buly.kr/90aYONY](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqa3V6X0FiMHZ6VTE1ZEJQQzBIeFRudmtrQjkyZ3xBQ3Jtc0tuOFk3ZEFfTW50UU1VbVVxd1RhOUdSVlgtYkR6Y1hoWlZQMVZpYkVoTGZjS2xfRVEwaV9FV0pvNEtQYmt1SDRxMW41Zzd3bjFoOXBpcDZfSWswNlJKR19Hc0NvbXpndUN0Ym9HRWVnNUpGYXQ2OEVVZw&q=https%3A%2F%2Fbuly.kr%2F90aYONY)\n- Length: Approximately 70 hours\n- How to Use Coupon Code: Register for Course → Enter Coupon Code in Coupon Selection Window → Register Coupon\n🔥 Link Collection 🔥\n[https://linktr.ee/teddynote](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqbnJNYm1ib3ZMM2lsZUN6QUFHV2gzMlZQX2diQXxBQ3Jtc0tucWJxcHFTLVpJUy1NbGxBTmh5cnpfTVVmY2IwZHd1dEJyeENkamNNWTQ0cGRGbl9NRXZZbXlyTk52aG41V1BRZmdlV0hFWGRNTDlneVI5Y25TTFFCZUM5aDFuOWNSdm03dlZxTktrcWRwT0c4U25TUQ&q=https%3A%2F%2Flinktr.ee%2Fteddynote)\n📘 Langchain Tutorial Free Ebook (wikidocs)\n[https://wikidocs.net/book/14314](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqbHZ4bnNVSUJuRWF5Qi1EU21RdVgzWTloYnl3QXxBQ3Jtc0trZ2ZEMEVqX3ZLU3FucEUyNVRQUExMVVVHSEJDY21NSEZLMG9Xc0x5MzFqbzlrTEF2dzByN0dfSFoydnVWR3VkTG1oRmVnQ0FlajRXTm1VcjZlLU9sdkRSSG14Zm11azlwamY0bi1uRlpWYzVEQTJOTQ&q=https%3A%2F%2Fwikidocs.net%2Fbook%2F14314)\n✅ Langchain Korean Tutorial Code Repository (GitHub)\n[https://github.com/teddylee777/langch...](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqbnVvUFFMaVZvQmdsQkk4bm0wOW56N3g5czlpd3xBQ3Jtc0trLXNjUWxHTEVBTHBfX2ZIOUEySkhiZkUyNl9QOXc0a2FnZWNLUXc0Y3JRV1YxRmRmbVJfN1hyOTZxNTRKQjFqQVZQZ0xRNko5SC1LaGNqR2RrNjU1SmFKOUhxblNsWTZEN0lXaTVrQnlKTWt6V0Q5WQ&q=https%3A%2F%2Fgithub.com%2Fteddylee777%2Flangchain-kr)\n---\n📍 \"Teddy Note's RAG Secret Notes\" Langchain Lecture: [https://fastcampus.co.kr/data\\_online\\_...](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqbGtzX2JOaERBWHFlNmZldGZpSlNzNVBVZ0d0d3xBQ3Jtc0tuYVdrQVkwTE1mNFVMU2Z3T2NpRGtIcjBRbGlySUdYV2ZKcTZwMWg4cUoyazQ0VGkxTEQ1cmdwRjNoYTZ4cHZyeUlQTXctY3U5RFJQb3NoMVh4WjZjZExzTXZQdE1iQ1lGY3lSRmNCcVRvWHo4TEFnRQ&q=https%3A%2F%2Ffastcampus.co.kr%2Fdata_online_teddy)\n📘 Langchain Korean Tutorial (Free Ebook): [https://wikidocs.net/book/14314](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqblZJNzdMQkNlUUl1MnFVOVI0alQ1V0hqQmliQXxBQ3Jtc0traDVWTlpKdHB3QXk1NHdna28yU2lCYjAwaUdZN25CSExjTkN2QkZ6QXY0NlFVWjR3ejFvWks4RzR2d1REaXBuMm15aEpDSWdEODB1LUJTQmtuSHhXZl9zQjhxRDI2ejNUR25FejVfVzhiR05tRXA3MA&q=https%3A%2F%2Fwikidocs.net%2Fbook%2F14314)\n📝 Teddy Note (GitHub Blog): [https://teddylee777.github.io](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqbmtTT1RlU2VJRkFJamZuRVdvVWRZMmNRYi02Z3xBQ3Jtc0tsdzdLaUVUTll4V2MwdzNRWU41aHJTMWVpa0VSLXFyUExjbDc3UVgySklLd2swbUFEdzNocDU0RjFQZDJVWElUZ21qYlp1ZGxVNXRRSUlVYmhiT0FJakN5MDRkRlJ1RFhxbVVTaW5wbTlKQS0tWGFESQ&q=https%3A%2F%2Fteddylee777.github.io%2F)\n💻 GitHub Source Code Repository: [https://github.com/teddylee777](https://www.youtube.com/redirect?event=video_description&redir_token=QUFFLUhqbG1BdXNjTVplS05rTlozLTUzdS1wSWxhZExWUXxBQ3Jtc0tsNndxVTRCTkRPd3R6WjlzTGRmNThSS3UtbDZoaHhQNm1BSTYwOHVrRW1DTjg4OGJQeVNYZkxQempzanh0WExaR1RMWVlyQ3JPU3VUMEZoa3dNeHJIUV9odDRqdXg2RmwzQzRPWjl4QWRUREZOaTNnQQ&q=https%3A%2F%2Fgithub.com%2Fteddylee777)\n\n\n\n[Read more](/watch?v=zybyszetEcE)\n\nOur members\nThank you, channel members!\n\nJoin\n\n## [Videos](/@teddynote/videos?view=0&sort=dd&shelf_id=2)\n\n### [Introducing Deep Agent Builder, an agent builder built with natural language.](/watch?v=QI2KVJ2ciiY \"Introducing Deep Agent Builder, an agent builder built with natural language.\")\n\n### [LangSmith Agent Builder, the first #no-code agent builder by #langchain](/watch?v=DGgvu-ALJx0 \"LangSmith Agent Builder, the first #no-code agent builder by #langchain\")\n\n### [Custom chatbot interface for LangGraph builder](/watch?v=DMQXpZXdNJ8 \"Custom chatbot interface for LangGraph builder\")\n\n### [#MCP #A2A What are the selection criteria when developing?](/watch?v=1guF3c-jWBk \"#MCP #A2A What are the selection criteria when developing?\")\n\n### [Exploring the Possibilities of #MCP X #A2A Enterprise-Oriented Security Design Architecture](/watch?v=ENLQA0GH36g&pp=0gcJCZEKAYcqIYzv \"Exploring the Possibilities of #MCP X #A2A Enterprise-Oriented Security Design Architecture\")\n\n### [🔥How to make RAG into #MCP (claude desktop, cursor)🔥](/watch?v=0etZjVebcu4 \"🔥How to make RAG into #MCP (claude desktop, cursor)🔥\")"}, {"url": "https://www.youtube.com/@teddynote/videos", "title": "테디노트 TeddyNote - YouTube", "content": "TermsPrivacyPolicy & SafetyHow YouTube worksTest new featuresNFL Sunday Ticket. ### Introducing Deep Agent Builder, an agent builder built with natural language. ### LangSmith Agent Builder, the first #no-code agent builder by #langchain. ### Custom chatbot interface for LangGraph builder. ### Previewing the Future of AI Agents with #Palantir #Ontology. ### 🔥 Instead of Cursor AI, create your own #MCP agent app! We've taken a look! And we've prepared a #tutorial, too🔥. ### #teddyflow 로 dify, langgraph, n8n 을 한 번에 연결해서 사용하기. ### Building a #dify custom tool (#upstage parser)\"). ### How to use the #Upstage document parser (server, client) built with #LangGraph built with #LangGraph\"). 혼자\\_떠들기.mp4 - YouTube 라이브편. ### Building an Agentic AI System Using #LangGraph (Agentic AI Meetup 2025 Q1)\"). ### #I connected #dify to #Obsidian and applied RAG / Agent / Workflow to Obsidian Note. ### I automated the title, metadata, and summary tasks in my #Obsidian notes. ### 새해 시작은 NO코드 #RAG #Agent #Workflow 구축해보기!", "score": 0.8106142, "raw_content": "Back\n\n[Sign in](https://accounts.google.com/ServiceLogin?service=youtube&uilel=3&passive=true&continue=https%3A%2F%2Fwww.youtube.com%2Fsignin%3Faction_handle_signin%3Dtrue%26app%3Ddesktop%26hl%3Den%26next%3Dhttps%253A%252F%252Fwww.youtube.com%252F%2540teddynote%252Fvideos&hl=en&ec=65620)\n\n[About](https://www.youtube.com/about/)[Press](https://www.youtube.com/about/press/)[Copyright](https://www.youtube.com/about/copyright/)[Contact us](/t/contact_us/)[Creators](https://www.youtube.com/creators/)[Advertise](https://www.youtube.com/ads/)[Developers](https://developers.google.com/youtube)\n\n[Terms](/t/terms)[Privacy](/t/privacy)[Policy & Safety](https://www.youtube.com/about/policies/)[How YouTube works](https://www.youtube.com/howyoutubeworks?utm_campaign=ytgen&utm_source=ythp&utm_medium=LeftNav&utm_content=txt&u=https%3A%2F%2Fwww.youtube.com%2Fhowyoutubeworks%3Futm_source%3Dythp%26utm_medium%3DLeftNav%26utm_campaign%3Dytgen)[Test new features](/new)[NFL Sunday Ticket](https://tv.youtube.com/learn/nflsundayticket)\n\n© 2026 Google LLC\n\n\n\n\n\n\n\n\n\n\n\n\n\n\n\n\n\n[36:19\n\n36:19\n\nNow playing](/watch?v=QI2KVJ2ciiY)\n[36:19\n\n36:19\n\n36:19\n\nNow playing](/watch?v=QI2KVJ2ciiY)\n\n### [Introducing Deep Agent Builder, an agent builder built with natural language.](/watch?v=QI2KVJ2ciiY \"Introducing Deep Agent Builder, an agent builder built with natural language.\")\n\n•\n\n•\n\n3K views\n7 days ago\n\n[13:55\n\n13:55\n\nNow playing](/watch?v=DGgvu-ALJx0)\n[13:55\n\n13:55\n\n13:55\n\nNow playing](/watch?v=DGgvu-ALJx0)\n\n### [LangSmith Agent Builder, the first #no-code agent builder by #langchain](/watch?v=DGgvu-ALJx0 \"LangSmith Agent Builder, the first #no-code agent builder by #langchain\")\n\n•\n\n•\n\n4.3K views\n2 months ago\n\n[9:22\n\n9:22\n\nNow playing](/watch?v=DMQXpZXdNJ8)\n[9:22\n\n9:22\n\n9:22\n\nNow playing](/watch?v=DMQXpZXdNJ8)\n\n### [Custom chatbot interface for LangGraph builder](/watch?v=DMQXpZXdNJ8 \"Custom chatbot interface for LangGraph builder\")\n\n•\n\n•\n\n3.4K views\n2 months ago\n\n[10:07\n\n10:07\n\nNow playing](/watch?v=1guF3c-jWBk)\n[10:07\n\n10:07\n\n10:07\n\nNow playing](/watch?v=1guF3c-jWBk)\n\n### [#MCP #A2A What are the selection criteria when developing?](/watch?v=1guF3c-jWBk \"#MCP #A2A What are the selection criteria when developing?\")\n\n•\n\n•\n\n3.6K views\n6 months ago\n\n[33:59\n\n33:59\n\nNow playing](/watch?v=ENLQA0GH36g)\n[33:59\n\n33:59\n\n33:59\n\nNow playing](/watch?v=ENLQA0GH36g)\n\n### [Exploring the Possibilities of #MCP X #A2A Enterprise-Oriented Security Design Architecture](/watch?v=ENLQA0GH36g \"Exploring the Possibilities of #MCP X #A2A Enterprise-Oriented Security Design Architecture\")\n\n•\n\n•\n\n2.1K views\n6 months ago\n\n[16:26\n\n16:26\n\nNow playing](/watch?v=0etZjVebcu4)\n[16:26\n\n16:26\n\n16:26\n\nNow playing](/watch?v=0etZjVebcu4)\n\n### [🔥How to make RAG into #MCP (claude desktop, cursor)🔥](/watch?v=0etZjVebcu4 \"🔥How to make RAG into #MCP (claude desktop, cursor)🔥\")\n\n•\n\n•\n\n13K views\n7 months ago\n\n[23:16\n\n23:16\n\nNow playing](/watch?v=GKOWbcNidjo)\n[23:16\n\n23:16\n\n23:16\n\nNow playing](/watch?v=GKOWbcNidjo)\n\n### [Reasoning, RAG, 추론 모델의 현재와 미래](/watch?v=GKOWbcNidjo \"Reasoning, RAG, 추론 모델의 현재와 미래\")\n\n•\n\n•\n\n6.9K views\n7 months ago\n\n[12:41\n\n12:41\n\n12:41\n\nNow playing](/watch?v=6Zd7d1iqk5I&pp=0gcJCZEKAYcqIYzv)\n\n### [지식을 생산하는 AI, 인간 연구자의 역할은?](/watch?v=6Zd7d1iqk5I&pp=0gcJCZEKAYcqIYzv \"지식을 생산하는 AI, 인간 연구자의 역할은?\")\n\n•\n\n•\n\n2.3K views\n7 months ago\n\n[10:00\n\n10:00\n\n10:00\n\nNow playing](/watch?v=nyZnrKVaIXU)\n\n### [에이전트 시스템에서 #A2A 와 #MCP 의 의미](/watch?v=nyZnrKVaIXU \"에이전트 시스템에서 #A2A 와 #MCP 의 의미\")\n\n•\n\n•\n\n15K views\n8 months ago\n\n[14:57\n\n14:57\n\n14:57\n\nNow playing](/watch?v=ctKz2bkgkPQ)\n\n### [Previewing the Future of AI Agents with #Palantir #Ontology](/watch?v=ctKz2bkgkPQ \"Previewing the Future of AI Agents with #Palantir #Ontology\")\n\n•\n\n•\n\n22K views\n8 months ago\n\n[31:31\n\n31:31\n\n31:31\n\nNow playing](/watch?v=Zk3ipzTMe1g)\n\n### [2025 Document Parser Comparison! Synap DocuAnalyzer vs. Upstage Document Parse](/watch?v=Zk3ipzTMe1g \"2025 Document Parser Comparison! Synap DocuAnalyzer vs. Upstage Document Parse\")\n\n•\n\n•\n\n7.4K views\n9 months ago\n\n[2:57:06\n\n2:57:06\n\n2:57:06\n\nNow playing](/watch?v=W_uwR_yx4-c)\n\n### [🔥 #LangGraph 개념 완전 정복 몰아보기(3시간) 🔥](/watch?v=W_uwR_yx4-c \"🔥 #LangGraph 개념 완전 정복 몰아보기(3시간) 🔥\")\n\n•\n\n•\n\n114K views\n9 months ago\n\n[12:19\n\n12:19\n\n12:19\n\nNow playing](/watch?v=s-rDDqcGymk)\n\n### [#MCP 에이전트 공개(동적 도구 설정 대시보드, 시스템 프롬프트 설정, 다양한 모델)](/watch?v=s-rDDqcGymk \"#MCP 에이전트 공개(동적 도구 설정 대시보드, 시스템 프롬프트 설정, 다양한 모델)\")\n\n•\n\n•\n\n6.1K views\n9 months ago\n\n[10:11\n\n10:11\n\n10:11\n\nNow playing](/watch?v=A31X4gdGbKw)\n\n### [🔥 #langgraph 에이전트 + #mcp 도구 서버로 띄우고 프론트와 쉽게 연결하기🔥](/watch?v=A31X4gdGbKw \"🔥 #langgraph 에이전트 + #mcp 도구 서버로 띄우고 프론트와 쉽게 연결하기🔥\")\n\n•\n\n•\n\n9.9K views\n10 months ago\n\n[19:06\n\n19:06\n\n19:06\n\nNow playing](/watch?v=ISrYHGg2C2c&pp=0gcJCZEKAYcqIYzv)\n\n### [🔥 Instead of Cursor AI, create your own #MCP agent app! 🔥](/watch?v=ISrYHGg2C2c&pp=0gcJCZEKAYcqIYzv \"🔥 Instead of Cursor AI, create your own #MCP agent app! 🔥\")\n\n•\n\n•\n\n50K views\n10 months ago\n\n[29:29\n\n29:29\n\n29:29\n\nNow playing](/watch?v=VKIl0TIDKQg&pp=0gcJCZEKAYcqIYzv)\n\n### [🔥 Why is #MCP so popular? We've taken a look! And we've prepared a #tutorial, too🔥](/watch?v=VKIl0TIDKQg&pp=0gcJCZEKAYcqIYzv \"🔥 Why is #MCP so popular? We've taken a look! And we've prepared a #tutorial, too🔥\")\n\n•\n\n•\n\n98K views\n10 months ago\n\n[5:28\n\n5:28\n\n5:28\n\nNow playing](/watch?v=BkJ6hiZSnR0)\n\n### [#teddyflow 로 dify, langgraph, n8n 을 한 번에 연결해서 사용하기](/watch?v=BkJ6hiZSnR0 \"#teddyflow 로 dify, langgraph, n8n 을 한 번에 연결해서 사용하기\")\n\n•\n\n•\n\n4.5K views\n10 months ago\n\n[15:13\n\n15:13\n\n15:13\n\nNow playing](/watch?v=xWG4nYBZTsE)\n\n### [Building a #dify custom tool (#upstage parser)](/watch?v=xWG4nYBZTsE \"Building a #dify custom tool (#upstage parser)\")\n\n•\n\n•\n\n4.3K views\n10 months ago\n\n[10:35\n\n10:35\n\n10:35\n\nNow playing](/watch?v=gEjAq3Jnu94)\n\n### [How to use the #Upstage document parser (server, client) built with #LangGraph](/watch?v=gEjAq3Jnu94 \"How to use the #Upstage document parser (server, client) built with #LangGraph\")\n\n•\n\n•\n\n5.3K views\n10 months ago\n\n[7:26\n\n7:26\n\n7:26\n\nNow playing](/watch?v=iUazlZsVzhw)\n\n### [EP01. 혼자\\_떠들기.mp4 - YouTube 라이브편](/watch?v=iUazlZsVzhw \"EP01. 혼자_떠들기.mp4 - YouTube 라이브편\")\n\n•\n\n•\n\n1.5K views\n10 months ago\n\n[38:48\n\n38:48\n\n38:48\n\nNow playing](/watch?v=edsshVochqM)\n\n### [Building an Agentic AI System Using #LangGraph (Agentic AI Meetup 2025 Q1)](/watch?v=edsshVochqM \"Building an Agentic AI System Using #LangGraph (Agentic AI Meetup 2025 Q1)\")\n\n•\n\n•\n\n17K views\n10 months ago\n\n[19:56\n\n19:56\n\n19:56\n\nNow playing](/watch?v=-Jym-zji7YI)\n\n### [#LangSmith Playground 로 프롬프트 실험하는 방법(스키마, Tool, Canvas)](/watch?v=-Jym-zji7YI \"#LangSmith Playground 로 프롬프트 실험하는 방법(스키마, Tool, Canvas)\")\n\n•\n\n•\n\n3.6K views\n11 months ago\n\n[8:13\n\n8:13\n\n8:13\n\nNow playing](/watch?v=dhwhAiGPe9c&pp=0gcJCZEKAYcqIYzv)\n\n### [#GTC 이벤트 참여하고 RTX 4080 의 주인공이 되세요!](/watch?v=dhwhAiGPe9c&pp=0gcJCZEKAYcqIYzv \"#GTC 이벤트 참여하고 RTX 4080 의 주인공이 되세요!\")\n\n•\n\n•\n\n1.7K views\n11 months ago\n\n[8:41\n\n8:41\n\nNow playing](/watch?v=1OKglcbftY8)\n\n### [❤️[책 소개+출간 이벤트] 일잘러의 비밀, 챗GPT와 GPTs로 나만의 AI 챗봇 만들기❤️](/watch?v=1OKglcbftY8 \"❤️[책 소개+출간 이벤트] 일잘러의 비밀, 챗GPT와 GPTs로 나만의 AI 챗봇 만들기❤️\")\n\n[14:30\n\n14:30\n\nNow playing](/watch?v=zdEev8vT_zg)\n\n### [#I connected #dify to #Obsidian and applied RAG / Agent / Workflow to Obsidian Note.](/watch?v=zdEev8vT_zg \"#I connected #dify to #Obsidian and applied RAG / Agent / Workflow to Obsidian Note.\")\n\n[6:55\n\n6:55\n\nNow playing](/watch?v=z5Zo6vrYdFk)\n\n### [I automated the title, metadata, and summary tasks in my #Obsidian notes. (Free template sharing)](/watch?v=z5Zo6vrYdFk \"I automated the title, metadata, and summary tasks in my #Obsidian notes. (Free template sharing)\")\n\n[21:06\n\n21:06\n\nNow playing](/watch?v=9XQDpIlB3jk)\n\n### [코딩 과외 선생님을 만들어 봤습니다.](/watch?v=9XQDpIlB3jk \"코딩 과외 선생님을 만들어 봤습니다.\")\n\n[26:40\n\n26:40\n\nNow playing](/watch?v=OTsf94r_BkQ)\n\n### [새해 시작은 NO코드 #RAG #Agent #Workflow 구축해보기!](/watch?v=OTsf94r_BkQ \"새해 시작은 NO코드 #RAG #Agent #Workflow 구축해보기!\")"}]"

additional_kwargs: {}

response_metadata: {}

type: "tool"

name: "tavily_web_search"

id: "f9623249-518c-4fa0-a77b-458dd292bad1"

tool_call_id: "call_3C93FykeMqVTnWAT1GdfXgOO"

artifact: None

status: "success"

==============

STEP: chatbot

==============

content: "테디노트(TeddyNote)는 데이터 분석, 머신러닝, 딥러닝, LLM(대형 언어 모델)에 관한 다양한 내용을 다루는 유튜브 채널입니다. 이 채널은 개발 중심의 콘텐츠를 제공하며, 구독자는 50.2K명입니다. 최근 로Streamed 비디오로 다양한 AI 관련 토픽을 다루고 있습니다.

몇 가지 비디오 예시:

1. [Deep Agents와 Agentic Coding에 대한 강연](https://www.youtube.com/watch?v=SKqCA-43nPM)

2. [LangChain과의 연계된 Q&A 세션](https://www.youtube.com/watch?v=QAMDYNaDegM)

3. [AI 개발의 미래에 대한 논의](https://www.youtube.com/watch?v=qq8HxJxy7gE)

채널 링크: [테디노트 유튜브](https://www.youtube.com/@teddynote/streams)

더 많은 비디오와 정보를 보려면 채널을 방문해 보세요!"

additional_kwargs: {"refusal": None}

response_metadata:

token_usage:

completion_tokens: 223

prompt_tokens: 16922

total_tokens: 17145

completion_tokens_details: {"accepted_prediction_tokens": 0, "audio_tokens": 0, "reasoning_tokens": 0, "rejected_prediction_tokens": 0}

prompt_tokens_details: {"audio_tokens": 0, "cached_tokens": 0}

model_provider: "openai"

model_name: "gpt-4o-mini-2024-07-18"

system_fingerprint: "fp_6c0d1490cb"

id: "chatcmpl-D7bcw0ZVQDKojFQfMzeY4CYWdzs5R"

service_tier: "default"

finish_reason: "stop"

logprobs: None

type: "ai"

name: None

id: "lc_run--019c4642-c1bb-7750-9e6a-0c784a435ada-0"

tool_calls:

invalid_tool_calls:

usage_metadata:

input_tokens: 16922

output_tokens: 223

total_tokens: 17145

input_token_details: {"audio": 0, "cache_read": 0}

output_token_details: {"audio": 0, "reasoning": 0}

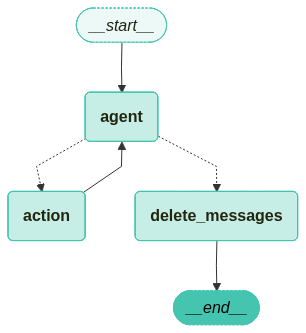

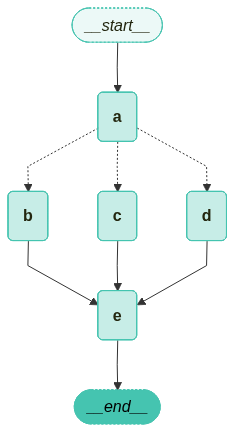

5. Agent에 메모리 추가

현재까지 만든 챗봇은 과거 상호작용을 스스로 기억할 수 없어 일관된 다중 턴 대화를 진행하는 데 제한이 있습니다. 이번 예제에서는 이를 해결하기 위해 메모리를 추가해 보고자 합니다.

이번에는 pre-built 되어 있는 ToolNode와 tools_condition을 활용합니다. 이전 항목까지 만들어 봤던 챗봇은 이제 도구를 사용하여 사용자 질문에 답할 수 있지만, 이전 상호작용의 context를 기억하지 못합니다. 이는 멀티턴(multiturn) 대화를 진행하는 능력을 제한합니다.

LangGraph는 persistent checkpointing을 통해 이 문제를 해결합니다.

그래프를 컴파일할 때 checkpointer를 제공하고 그래프를 호출할 때 thread_id를 제공하면, LangGraph는 각 단계 후 상태를 자동으로 저장합니다. 동일한 thread_id를 사용하여 그래프를 다시 호출하면, 그래프는 저장된 상태를 로드하여 챗봇이 이전에 중단한 지점에서 대화를 이어갈 수 있게 합니다.

예제 코드 실행에 앞서 코드 실행에 필요한 라이브러리 설치를 먼저 진행해 줍니다.

!pip install -U langchain-openai langchain-teddynote langchain-core

우선 MemorySaver checkpointer를 생성합니다.

from langgraph.checkpoint.memory import MemorySaver

# 메모리 저장소 생성

memory = MemorySaver()

이번 예제에서는 in-memory checkcpointer를 사용합니다.

from typing import Annotated

from typing_extensions import TypedDict

from langchain_openai import ChatOpenAI

from langchain_teddynote.tools.tavily import TavilySearch

from langgraph.graph import StateGraph, START, END

from langgraph.graph.message import add_messages

from langgraph.prebuilt import ToolNode, tools_condition

## 1. 상태 정의

class State(TypedDict):

# 메시지 목록 주석 추가

messages: Annotated[list, add_messages]

## 2. 도구 정의 및 바인딩

tool = TavilySearch(max_results=3)

tools = [tool]

# LLM 초기화

llm = ChatOpenAI(model="gpt-4o-mini")

# 도구와 LLM 결합

llm_with_tools = llm.bind_tools(tools)

## 3. 노드 추가

# 챗봇 함수 정의

def chatbot(state: State):

return {"messages": [llm_with_tools.invoke(state["messages"])]}

# 상태 그래프 생성

graph_builder = StateGraph(State)

# 챗봇 노드 추가

graph_builder.add_node("chatbot", chatbot)

# 도구 노드 생성 및 추가

tool_node = ToolNode(tools=[tool])

# 도구 노드 추가

graph_builder.add_node("tools", tool_node)

# 조건부 엣지

graph_builder.add_conditional_edges(

"chatbot",

tools_condition,

)

## 4. 엣지 추가

# tools -> chatbot

graph_builder.add_edge("tools", "chatbot")

# START -> chatbot

graph_builder.add_edge(START, "chatbot")

# chatbot -> END

graph_builder.add_edge("chatbot", END)

마지막으로, 제공된 checkpointer를 사용하여 그래프를 컴파일 합니다.

# 그래프 빌더 컴파일

graph = graph_builder.compile(checkpointer=memory)

5.1 RunnableConfig 설정

RunnableConfig을 정의하고 recursion_limit과 thread_id를 설정합니다.

recursion_limit: 최대 방문할 노드 수, 그 이상은 RecursionError 발생thread_id: 스레드 ID 설정

thread_id는 대화 세션을 구분하는데 사용됩니다. 즉, 메모리의 저장은 thread_id에 따라 개별적으로 이루어집니다.

from langchain_core.runnables import RunnableConfig

config = RunnableConfig(

recursion_limit = 10, # 최대 10개의 노드까지 방문, 그 이상은 RecursionError 발생

configurable={"thread_id": "1"} # 스레드 ID 설정, 딕셔너리 형태로 수정

)

question = (

"내 이름은 `테디노트` 입니다. YouTube 채널을 운영하고 있어요. 만나서 반가워요"

)

for event in graph.stream({"messages": [("user", question)]}, config=config):

for value in event.values():

value["messages"][-1].pretty_print()

Output:

================================== Ai Message ==================================

안녕하세요, 테디노트님! 만나서 반갑습니다. YouTube 채널에 대해 좀 더 알려주실 수 있나요? 어떤 내용을 다루고 계신지 궁금합니다!

# 이어지는 질문

question = "제 이름이 뭐라고 했죠?"

for event in graph.stream({"messages": [("user", question)]}, config=config):

for value in event.values():

value["messages"][-1].pretty_print()

Output:

================================== Ai Message ==================================

당신의 이름은 테디노트입니다!

이번엔 RunnableConfig의 thread_id를 변경한 뒤, 이전 대화 내용을 기억하고 있는지 물어보도록 하겠습니다.

from langchain_core.runnables import RunnableConfig

question = "제 이름이 뭐라고 했죠?"

config = RunnableConfig(

recursion_limit =10,

configurable={"thread_id": "2"},

)

for event in graph.stream({"messages": [("user", question)]}, config=config):

for value in event.values():

value["messages"][-1].pretty_print()

Output:

================================== Ai Message ==================================

죄송하지만, 이전 대화 내용을 기억할 수 없어서 귀하의 이름을 알 수 없습니다. 다시 말씀해 주실 수 있나요?

5.2 스냅샷: 저장된 State 확인

LangGraph의 Snapshot은 그래프의 특정 시점의 상태(State)를 그대로 사진 찍듯 저장해두는 기능입니다. 이 기능은 단순히 데이터를 저장하는 것을 넘어, 복잡한 AI 에이전트를 제어하는 데 있어 필수적인 역할을 합니다.

LangGraph의 Snapshot 기능이 주로 사용되는 곳은 다음과 같습니다.

-

체크포인트(checkpointing)를 통한 상태 복구

에이전트가 작업을 수행하다가 오류가 나거나 서버가 다운될 수 있습니다. 이때 스냅샷이 있다면 처음부터 다시 시작할 필요 없이 마지막으로 성공적으로 저장된 스냅샷 지점부터 작업을 재개하도록 할 수 있습니다.

-

타임머신 기능 (Time Travel & Debugging)

개발 과정에서 에이전트가 왜 이상한 답변을 했는지 파악해야 할 때가 있습니다.

- 활용: 과거 특정 시점의 스냅샷으로 돌아가서 당시의 상태값(변수, 대화 기록 등)을 확인합니다.

- 장점: 복잡한 루프 구조 내에서 발생한 논리적 오류를 추적하기가 쉬워집니다.

-

사람의 승인 단계 (Human-in-the-loop)

중요한 작업(예: 이메일 발송, 결제, 데이터 삭제)을 수행하기 전, 에이전트를 ‘일시 정지’ 시켜야 할 때 사용합니다.

-

상태 수정 및 재시도 (State Modification)

과거의 상태로 돌아가는 것뿐만 아니라, 그 상태의 내용을 살짝 수정해서 다시 실행해 볼 수 있습니다.

Checkpoint에는 현재 상태 값, 해당 구성, 그리고 처리할 next 노드가 포함되어 있습니다. 주어진 설정에서 그래프의 state를 검사하려면 언제든지 get_state(config)를 호출하여 설정하면 됩니다.

from langchain_core.runnables import RunnableConfig

config = RunnableConfig(

configurable={"thread_id": "1"} # 스레드 ID 설정

)

# 그래프 상태 스냅샷 생성

snapshot = graph.get_state(config)

snapshot.values["messages"]

Output:

[HumanMessage(content='내 이름은 `테디노트` 입니다. YouTube 채널을 운영하고 있어요. 만나서 반가워요', additional_kwargs={}, response_metadata={}, id='e54e310e-2a41-43bd-a6c7-8200088a117f'),

AIMessage(content='안녕하세요, 테디노트님! 만나서 반갑습니다. YouTube 채널에 대해 좀 더 알려주실 수 있나요? 어떤 내용을 다루고 계신지 궁금합니다!', additional_kwargs={'refusal': None}, response_metadata={'token_usage': {'completion_tokens': 43, 'prompt_tokens': 118, 'total_tokens': 161, 'completion_tokens_details': {'accepted_prediction_tokens': 0, 'audio_tokens': 0, 'reasoning_tokens': 0, 'rejected_prediction_tokens': 0}, 'prompt_tokens_details': {'audio_tokens': 0, 'cached_tokens': 0}}, 'model_provider': 'openai', 'model_name': 'gpt-4o-mini-2024-07-18', 'system_fingerprint': 'fp_f4ae844694', 'id': 'chatcmpl-D7chAViMqCzuEd7x5jnpAuwuenRGO', 'service_tier': 'default', 'finish_reason': 'stop', 'logprobs': None}, id='lc_run--019c4681-6593-7640-abe7-3151f9b051b2-0', tool_calls=[], invalid_tool_calls=[], usage_metadata={'input_tokens': 118, 'output_tokens': 43, 'total_tokens': 161, 'input_token_details': {'audio': 0, 'cache_read': 0}, 'output_token_details': {'audio': 0, 'reasoning': 0}}),

HumanMessage(content='제 이름이 뭐라고 했죠?', additional_kwargs={}, response_metadata={}, id='9d28957e-a10f-4917-b0ac-945bfc01bd6e'),

AIMessage(content='당신의 이름은 테디노트입니다!', additional_kwargs={'refusal': None}, response_metadata={'token_usage': {'completion_tokens': 12, 'prompt_tokens': 176, 'total_tokens': 188, 'completion_tokens_details': {'accepted_prediction_tokens': 0, 'audio_tokens': 0, 'reasoning_tokens': 0, 'rejected_prediction_tokens': 0}, 'prompt_tokens_details': {'audio_tokens': 0, 'cached_tokens': 0}}, 'model_provider': 'openai', 'model_name': 'gpt-4o-mini-2024-07-18', 'system_fingerprint': 'fp_f4ae844694', 'id': 'chatcmpl-D7chaALKD0VdcmXuPFCE5kQ38ia1S', 'service_tier': 'default', 'finish_reason': 'stop', 'logprobs': None}, id='lc_run--019c4681-d054-7e02-a1be-025e5bbbf8c5-0', tool_calls=[], invalid_tool_calls=[], usage_metadata={'input_tokens': 176, 'output_tokens': 12, 'total_tokens': 188, 'input_token_details': {'audio': 0, 'cache_read': 0}, 'output_token_details': {'audio': 0, 'reasoning': 0}})]

6. LangGraph 노드의 단계별 스트리밍 출력

노드별 스트리밍 출력 기능은 실제 프로덕션 환경의 LLM 서비스를 구축할 때 필수적인 핵심 기능입니다. 그 이유는 다음과 같습니다.

- 사용자 경험(UX)의 혁신: “기다림을 소통으로”

LLM 에이전트가 복잡한 추론을 하거나 여러 도구(Tool)를 실행할 때, 전체 결과가 나올 때까지 빈 화면만 보여주는 것은 최악의 UX라고 볼 수 있습니다.

- 시각적 피드백: 노드별 스트리밍을 사용하면 “에이전트가 지금 검색 중입니다…”, “결과를 요약하고 있습니다…“와 같은 진행 상황을 실시간으로 보여줄 수 있습니다.

- 체감 대기 시간 감소: 사용자는 결과가 한꺼번에 쏟아지는 것보다 조금씩 출력되는 과정을 볼 때 훨씬 더 서비스가 빠르고 신뢰할 수 있다고 느낍니다.

- 디버깅과 관찰 가능성 (Observability)

개발자 입장에서 LangGraph는 여러 노드가 얽혀 있는 복잡한 시스템입니다.

- 중간 과정 추적: 어떤 노드에서 시간이 오래 걸리는지, 어떤 노드에서 잘못된 데이터가 생성되는지 스트리밍을 통해 실시간으로 모니터링 할 수 있습니다.

- 상태 변화 확인:

astream_events같은 기능을 사용하면 노드 사이에서State가 어떻게 변하는지 (TypedDict에 데이터가 어떻게 쌓이는지) 실시간으로 파악되어 문제 해결 속도가 비약적으로 빨라집니다.

- 복합 에이전트 제어 (Multi-Agent Interaction)

여러 에이전트가 협업하는 구조에서 스트리밍은 시스템 간의 ‘심박수’를 체크하는 것과 같습니다.

- 중간 개입 가능성: 스트리밍되는 출력을 보고 있다가, 에이전트가 엉뚱한 방향으로 가고 있다면 즉시 프로세스를 중단 시키거나 수정할 수 있는 기반이 됩니다.

실습 코드 실행에 필요한 라이브러리 설치를 진행해 줍니다.

!pip install -U langchain-teddynote langchain-openai langchain-core

우선 이전에 진행했었던 도구와 LLM 그리고 Graph를 그대로 사용하고자 합니다.

from typing import Annotated, List, Dict

from typing_extensions import TypedDict

from langchain_core.tools import tool

from langchain_openai import ChatOpenAI

from langgraph.checkpoint.memory import MemorySaver

from langgraph.graph import StateGraph, START, END

from langgraph.graph.message import add_messages

from langgraph.prebuilt import ToolNode, tools_condition

from langchain_teddynote.graphs import visualize_graph

from langchain_teddynote.tools import GoogleNews

## 1. 상태 정의

class State(TypedDict):

messages: Annotated[list, add_messages]

dummy_data: Annotated[str, "dummy"]

## 2. 도구 정의 및 바인딩

# 키워드로 뉴스 검색하는 도구 생성

news_tool = GoogleNews()

@tool

def search_keyword(query: str) -> List[Dict[str, str]]:

"""Look up news by keyword"""

news_tool = GoogleNews()

return news_tool.search_by_keyword(query, k=5)

tools = [search_keyword]

# LLM 초기화

llm = ChatOpenAI(model="gpt-4o-mini")

# 도구와 LLM 결합

llm_with_tools = llm.bind_tools(tools)

## 3. 노드 추가

# 챗봇 함수 정의

def chatbot(state: State):

return {

"messages": [llm_with_tools.invoke(state["messages"])],

"dummy_data": "[chatbot] 호출, dummy data",

}

# 상태 그래프 생성

graph_builder = StateGraph(State)

# 챗봇 노드 추가

graph_builder.add_node("chatbot", chatbot)

# 도구 노드 생성 및 추가

tool_node = ToolNode(tools=tools)

# 도구 노드 추가

graph_builder.add_node("tools", tool_node)

# 조건부 엣지

graph_builder.add_conditional_edges(

"chatbot",

tools_condition,

)

## 4. 엣지 추가

# tools -> chatbot

graph_builder.add_edge("tools", "chatbot")

# START -> chatbot

graph_builder.add_edge(START, "chatbot")

# chatbot -> END

graph_builder.add_edge("chatbot", END)

## 5. 그래프 컴파일

graph = graph_builder.compile()

6.1 StateGraph의 stream 메서드

stream 메서드는 단일 입력에 대한 그래프 단계를 스트리밍하는 기능을 제공합니다.

매개변수는 다음과 같습니다.

input(Union[dict[str, Any], Any]): 그래프에 대한 입력config(Optional[RunnableConfig]): 실행 구성stream_mode(Optional[Union[StreamMode, list[StreamMode]]]): 출력 스트리밍 모드output_keys(Optional[Union[str, Sequence[str]]]): 스트리밍할 키interuupt_before(Optional[Union[All, Sequence[str]]]): 실행 전에 중단할 노드interrupt_after(Optional[Union[All, Sequence[str]]]): 실행 후에 중단할 노드debug(Optional[bool]): 디버그 정보 출력 여부subgraphs(bool): 하위 그래프 스트리밍 여부

반환값은 다음과 같습니다.

- Iterator[Union[dict[str, Any], Any]]: 그래프의 각 단계 출력, 출력 형태는

stream_mode에 따라 다름

주요 기능

- 입력된 설정에 따라 그래프 실행을 스트리밍 방식으로 처리

- 다양한 스트리밍 모드 지원(values, updates, debug)

- 콜백 관리 및 오류 처리

- 재귀 제한 및 중단 조건 처리

6.1.1 output_keys 옵션

output_keys 옵션은 스트리밍할 키를 지정하는데 사용됩니다. list 형식으로 지정할 수 있으며, channels에 정의된 키 중 하나여야 합니다.

매 단계마다 출력되는 State key가 많은 경우, 일부만 스트리밍하고 싶은 경우에 유용합니다.

# channels에 정의된 키 목록을 출력합니다.

print(list(graph.channels.keys()))

output_keys에 channels에 있는 키 중 하나인 dummy_data를 넣어보도록 하겠습니다.

question = "2025년 노벨 문학상 관련 뉴스를 알려주세요."

# 초기 입력 State 를 정의

input = State(dummy_data="테스트 문자열", messages=[("user", question)])

# config 설정

config = RunnableConfig(

recursion_limit=10, # 최대 10개의 노드까지 방문. 그 이상은 RecursionError 발생

configurable={"thread_id": "1"}, # 스레드 ID 설정

tags=["my-rag"], # Tag

)

for event in graph.stream(

input=input,

config=config,

output_keys=["dummy_data"],):

for key, value in event.items():

print(f"\n[{key}]\n")

# dummy_data가 존재하는 경우

if value:

print(value.keys())

if "dummy_data" in value:

print(value["dummy_data"])

출력을 해보면 dummy_data만 출력되는 것을 확인할 수 있습니다.

Output:

[chatbot]

dict_keys(['dummy_data'])

[chatbot] 호출, dummy data

[tools]

[chatbot]

dict_keys(['dummy_data'])

[chatbot] 호출, dummy data

6.1.2 stream_mode 옵션

LangGraph는 크게 두 가지 방식의 스트리밍을 지원합니다. stream_mode 옵션은 스트리밍 출력 모드를 지정하는데 사용됩니다.

- Values Streaming(stream_mode=”values”):

- 노드가 실행될 때마다 전체 상태(State) 값을 출력합니다. 현재 데이터가 어떻게 바뀌었는지 한 눈에 보기 좋습니다.

- Updates Streaming(stream_mode=”updates”):

- 해당 노드에서 새롭게 업데이트된 값만 출력합니다. 어떤 노드가 어떤 일을 했는지 명확히 알 수 있습니다.

우선 Values Streaming 예제부터 살펴보도록 하겠습니다.

question = "2025년 노벨 문학상 관련 뉴스를 알려주세요."

input = State(dummy_data="테스트 문자열", messages=[("user", question)])

config = RunnableConfig(

recursion_limit=10,

configurable={"thread_id": "1"},

tags=["my-tag"],

)

# values 모드로 스트리밍 출력

for event in graph.stream(

input=input,

stream_mode="values", # 기본값

):

for key, value in event.items():

# key 는 state 의 key 값

print(f"\n[ {key} ]\n")

if key == "messages":

print(f"메시지 개수: {len(value)}")

# print(value)

print("===" * 10, " 단계 ", "===" * 10)

Output:

[ messages ]

메시지 개수: 1

[ dummy_data ]

============================== 단계 ==============================

[ messages ]

메시지 개수: 2

[ dummy_data ]

============================== 단계 ==============================

[ messages ]

메시지 개수: 3

[ dummy_data ]

============================== 단계 ==============================

[ messages ]

메시지 개수: 4

[ dummy_data ]

============================== 단계 ==============================

다음으로는 Updates Streaming 입니다.

# 질문

question = "2025년 노벨 문학상 관련 뉴스를 알려주세요."

# 초기 입력 State 를 정의

input = State(dummy_data="테스트 문자열", messages=[("user", question)])

# config 설정

config = RunnableConfig(

recursion_limit=10, # 최대 10개의 노드까지 방문. 그 이상은 RecursionError 발생

configurable={"thread_id": "1"}, # 스레드 ID 설정

tags=["my-rag"], # Tag

)

# updates 모드로 스트리밍 출력

for event in graph.stream(

input=input,

stream_mode="updates", # 기본값

):

for key, value in event.items():

# key 는 노드 이름

print(f"\n[ {key} ]\n")

# value 는 노드의 출력값

print(value.keys())

# value 에는 state 가 dict 형태로 저장(values 의 key 값)

if "messages" in value:

print(f"메시지 개수: {len(value['messages'])}")

# print(value["messages"])

print("===" * 10, " 단계 ", "===" * 10)

이전의 Values Streaming 방식과는 다르게 출력되는 것이 적은 것을 확인할 수 있습니다. 노드에서 업데이트가 일어날 때마다 출력을 하기 때문에 그렇습니다.

Output:

[ chatbot ]

dict_keys(['messages', 'dummy_data'])

메시지 개수: 1

============================== 단계 ==============================

[ tools ]

dict_keys(['messages'])

메시지 개수: 1

============================== 단계 ==============================

[ chatbot ]

dict_keys(['messages', 'dummy_data'])

메시지 개수: 1

============================== 단계 ==============================

6.1.3 Token-level Streaming

노드 내부의 LLM이 생성하는 단어(토큰) 하나하나를 실시간으로 출력합니다. 우리가 Chat-GPT에서 보는 효과입니다.

question = "2025년 노벨 문학상 관련 뉴스를 알려주세요."

input = State(dummy_data="테스트 문자열", messages=[("user", question)])

config = RunnableConfig(

recursion_limit=10,

configurable={"thread_id": "1"},

tags=["my-tag"],

)

async for event in graph.astream_events(input, version="v2"):

kind = event["event"]

if kind == "on_chat_model_stream":

content = event["data"]["chunk"].content

if content:

print(content, end="|", flush=True)

| 각 토큰 뒤에 “ | “이 출력되도록 했습니다. 직접 실행을 해보면 토큰 하나 하나 출력되는 것을 확인할 수 있으며 모두 출력되면 아래 결과와 같이 각 토큰 뒤에 “ | “이 같이 출력된 결과를 볼 수 있습니다. |

Output:

202|5|년| 노|벨| 문|학|상|에| 관한| 주요| 뉴스|는| 다음|과| 같습니다|:

|1|.| **|헝|가|리| 작|가| 크|러스|너|호|르|커|이| 라|슬|로| 수|상|**|:| 크|러스|너|호|르|커|이| 라|슬|로|가| |202|5|년| 노|벨| 문|학|상을| 수|상|했습니다|.| [|뉴스|1|](|https|://|news|.google|.com|/rss|/articles|/|CB|Mi|W|k|FV|X|3|lx|TE|5|l|Y|ml|IQ|T|VO|Z|y|1|z|U|j|Z|r|N|0|t|Nb|V|d|PQ|j|J|1|MW|5|t|WU|hr|Uk|V|KV|j|RQ|TV|Q|3|em|tt|Rl|Y|4|T|1|gt|b|V|83|Q|y|1|ST|G|g|5|e|HY|0|d|Ux|6|c|DF|QM|2|F|OV|m|9|p|VG|x|X|Q|3|A|5|a|Gc|5|LV|Y|3|QQ|?|oc|=|5|)

|2|.| **|올|해| 노|벨| 문|학|상| 연|설|**|:| 문|학|이나| 소|설|에| 대한| 언|급| 없이| "|반|란|"|을| 꾀|한| 올해|의| 노|벨| 문|학|상| 연|설|이| 있|었습니다|.| [|한|겨|레|](|https|://|news|.google|.com|/rss|/articles|/|CB|Mi|Y|0|FV|X|3|lx|TE|1|QQ|0|RX|R|2|Z|ya|Gt|se|T|Q|4|U|j|J|4|Q|lg|3|N|El|p|Z|3|V|3|RT|M|3|c|3|Z|5|Q|z|ht|Zj|R|Z|b|TJ|m|M|054|OE|1|UM|V|9|n|R|21|Rc|G|ti|WG|Vi|X|z|M|4|MW|V|OV|29|Bd|E|J|x|LW|d|BV|1|VV|WT|gte|Dd|Y|d|0|x|Q|bl|FH|dm|1|x|Zw|?|oc|=|5|)

|3|.| **|문|학|계|와| 영화|광|들|**|:| |202|5|년| 노|벨| 문|학|상이| 문|학|계|보다| 영화|광|들| 사이|에서| 더| 많은| 환|호|를| 받|았|다는| 이야|기가| 있습니다|.| [|뉴스|와|이어|](|https|://|news|.google|.com|/rss|/articles|/|CB|Mi|X|0|FV|X|3|lx|TE|1|B|dk|Rm|W|kl|TW|l|I|0|MW|N|ub|1|N|Pa|Ux|ud|0|J|HR|j|V|h|W|l|BC|Y|zd|2|Y|1|RX|U|0|l|W|bk|9|f|Y|V|Z|SW|FF|Y|OS|1|GN|W|pv|Zj|ll|X|3|d|NX|3|dua|V|h|C|ck|d|J|dll|q|UE|t|U|Q|VN|ub|1|Za|OW|1|CO|Ug|0|OD|dj|?|oc|=|5|)

|4|.| **|크|러스|너|호|르|커|이|의| 문|학|적| 업|적|**|:| 헝|가|리| 작|가| 크|러스|너|호|르|커|이가| "|묵|시|록| 문|학|의| 거|장|"|으로| 평가|받|고| 있습니다|.| [|조|선|일보|](|https|://|news|.google|.com|/rss|/articles|/|CB|Mil|AF|B|VV|95|c|Ux|OM|m|5|p|N|0|py|Sz|N|1|T|0|da|Nk|ty|ej|R|xb|k|96|ak|F|EM|3|F|5|b|2|h|XN|3|h|TX|01|GT|n|RT|TV|FW|cm|Z|4|RW|04|b|E|45|M|3|Bs|N|FR|Mam|5|j|Vk|NI|b|GF|UW|V|d|X|RG|5|BM|H|had|E|1|MU|ER|GN|Fc|5|OW|t|4|RV|lx|US|1|p|W|VU|0|OE|JWT|3|dw|Z|2|RY|cz|Bs|Nz|ls|bl|N|LR|V|Fp|Q|1|B|2|b|2|R|ae|Fg|1|NT|RE|LU|dw|Y|V|9|NZ|j|I|0|M|1|N|f|0|g|Go|AU|FV|X|3|lx|TE|5|a|VW|FO|YX|lf|SG|Y|t|N|2|hr|UE|h|U|OH|p|L|ck|Nk|Uz|dx|W|DI|4|Y|0|Y|yc|W|FX|UX|NL|TX|V|OND|J|kd|FFD|bl|N|n|Z|mt|BZ|k|4|x|NU|t|SQ|09|D|dk|Ju|NT|dr|d|G|0|yd|z|NR|a|E|1|W|c|TRL|TX|l|HY|2|Z|QM|k|42|MU|h|RM|0|J|f|Z|3|Nu|T|j|RQ|b|W|sy|QU|ls|Y|k|01|Tm|Fp|VT|d|0|Z|Wh|HN|0|Vy|NG|F|ne|UJ|l|aj|Rp|TG|t|3|RW|l|OW|jl|Tb|DR|Sb|Hl|za|1|F|DT|FF|N|ZX|Na|ND|N|JU|W|Vm|Sw|?|oc|=|5|)

|더| 자세|한| 내용을| 원|하|시면| 각| 링크|를| 클릭|하여| 확인|하|실| 수| 있습니다|.|

6.1.4 interuupt_before와 interrupt_after 옵션

interuupt_before와 interuupt_after 옵션은 스트리밍 중단 시점을 지정하는 데 사용됩니다.

이 옵션들이 중요한 이유는 단순한 챗봇은 입력하면 결과가 나올 때까지 쭉 실행되지만, 실제 업무용 에이전트는 그렇지 않습니다.

- 인적 승인(Human-in-the-loop): 결제를 진행하거나, 중요 이메일을 발송하기 전, 반드시 사람의 확인을 받아야 합니다.

- 안전 장치: AI가 위험한 도구(DB 삭제 등)을 실행하기 직전에 멈춰 세워야 합니다.

- 협업: AI가 초안을 작성하면 사람이 수정하고, 수정한 상태에서 다시 AI가 작업을 이어가야 합니다.

interrupt 옵션은 바로 이런 일시정지와 개입을 가능하게 합니다.

interrupt_before: 지정된 노드 이전에 스트리밍 중단interrupt_after: 지정된 노드 이후에 스트리밍 중단

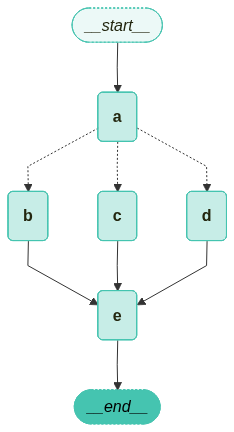

7. 중간단계 개입 되돌림을 통한 상태 수정과 Replay

7.1 중간 단계의 상태(State) 수동 업데이트

LangGraph는 중간 단계의 상태를 수동으로 업데이트 할 수 있는 방안을 제공하고 있습니다. 상태를 업데이트하면 에이전트의 행동을 수정하여 경로를 제어할 수 있으며, 심지어 과거를 수정할 수도 있습니다. 이 기능은 에이전트의 실수를 수정 하거나, 대체 경로를 탐색하거나, 특정 목표에 따라 에이전트의 동작을 변경할 때 특히 유용합니다.

이번 예제도 이전에 사용했던 동일한 그래프를 사용합니다.

from typing import Annotated

from typing_extensions import TypedDict

from langchain_teddynote.tools.tavily import TavilySearch

from langchain_openai import ChatOpenAI

from langgraph.checkpoint.memory import MemorySaver

from langgraph.graph import StateGraph, START, END

from langgraph.graph.message import add_messages

from langgraph.prebuilt import ToolNode, tools_condition

from langchain_teddynote.graphs import visualize_graph

########## 1. 상태 정의 ##########

# 상태 정의

class State(TypedDict):

# 메시지 목록 주석 추가

messages: Annotated[list, add_messages]

########## 2. 도구 정의 및 바인딩 ##########

# 도구 초기화

tool = TavilySearch(max_results=3)

# 도구 목록 정의

tools = [tool]

# LLM 초기화

llm = ChatOpenAI(model="gpt-4o-mini")

# 도구와 LLM 결합

llm_with_tools = llm.bind_tools(tools)

########## 3. 노드 추가 ##########

# 챗봇 함수 정의

def chatbot(state: State):

# 메시지 호출 및 반환

return {"messages": [llm_with_tools.invoke(state["messages"])]}

# 상태 그래프 생성

graph_builder = StateGraph(State)

# 챗봇 노드 추가

graph_builder.add_node("chatbot", chatbot)

# 도구 노드 생성 및 추가

tool_node = ToolNode(tools=tools)

# 도구 노드 추가

graph_builder.add_node("tools", tool_node)

# 조건부 엣지

graph_builder.add_conditional_edges(

"chatbot",

tools_condition,

)

########## 4. 엣지 추가 ##########

# tools > chatbot

graph_builder.add_edge("tools", "chatbot")

# START > chatbot

graph_builder.add_edge(START, "chatbot")

# chatbot > END

graph_builder.add_edge("chatbot", END)

########## 5. 그래프 컴파일 ##########

# 메모리 저장소 초기화

memory = MemorySaver()

# 그래프 빌더 컴파일

graph = graph_builder.compile(checkpointer=memory)

from langchain_core.runnables import RunnableConfig

question = "LangGraph가 무엇인지 조사하여 알려주세요!"

# 초기 입력 상태를 정의

input = State(messages=[("user", question)])

# config 설정

config = RunnableConfig(

configurable={"thread_id": "1"}, # 스레드 ID 설정

)

채널 목록을 출력하여 interrupt_before와 interrupt_after를 적용할 수 있는 목록을 출력합니다.

# 그래프 채널 목록 출력

list(graph.channels)

Output:

['messages',

'__start__',

'__pregel_tasks',

'branch:to:chatbot',

'branch:to:tools']

이제 여기서 “tools” 노드 전에 멈추도록 interrupt_before 값에 “tools”를 넣어주도록 하겠습니다.

# 그래프 스트림 호출

events = graph.stream(

input=input,

config=config,

interrupt_before=["tools"],

stream_mode="values"

)

for event in events:

if "messages" in event:

event["messages"][-1].pretty_print()

Output:

================================ Human Message =================================

LangGraph가 무엇인지 조사하여 알려주세요!

================================== Ai Message ==================================

Tool Calls:

tavily_web_search (call_B0nxGSYnBcp991t3VpISa9cX)

Call ID: call_B0nxGSYnBcp991t3VpISa9cX

Args:

query: LangGraph

현재 단계는 ToolNode에 의해 중단되었습니다. 가장 최근 메시지를 확인하면 ToolNode가 검색을 수행하기 전 query를 포함하고 있음을 알 수 있습니다.

여기서는 query가 단순하게 LangGraph라는 단어만을 포함하고 있습니다. 당연하게도 웹 검색 결과가 우리가 원하는 결과와 다를 수 있습니다.

# 그래프 상태 스냅샷 생성

snapshot = graph.get_state(config)

# 가장 최근 메시지 추출

last_message = snapshot.values["messages"][-1]

# 메시지 출력

last_message.pretty_print()

Output:

================================== Ai Message ==================================

Tool Calls:

tavily_web_search (call_B0nxGSYnBcp991t3VpISa9cX)

Call ID: call_B0nxGSYnBcp991t3VpISa9cX

Args:

query: LangGraph

7.2 사람의 개입(Human-in-the-loop)

만약, 사람이 중간에 개입하여 웹 검색 도구인 Tavily Tool의 검색 결과인 ToolMessage를 수정하여 LLM에게 전달하고 싶다면 어떻게 해야 할까요?

아래는 원래의 웹 검색 결과와는 조금 다른 수정한 가상의 웹 검색 결과를 만들어 보았습니다.

modified_search_result = """[수정된 웹 검색 결과]

LangGraph는 상태 기반의 다중 액터 애플리케이션을 LLM을 활용해 구축할 수 있도록 지원합니다.

LangGraph는 사이클 흐름, 제어 가능성, 지속성, 클라우드 배포 기능을 제공하는 오픈 소스 라이브러리입니다.

자세한 튜토리얼은 [LangGraph 튜토리얼](https://langchain-ai.github.io/langgraph/tutorials/) 과

테디노트의 [랭체인 한국어 튜토리얼](https://wikidocs.net/233785) 을 참고하세요."""

다음으로 수정한 검색 결과를 ToolMessage에 주입합니다. 여기서 메시지를 수정하려면 수정하고자 하는 Message와 일치하는 tool_call_id를 지정해야 합니다.

# 수정하고자 하는 'ToolMessage'의 'tool_call_id' 추출

tool_call_id = last_message.tool_calls[0]["id"]

print(tool_call_id)

Output:

call_B0nxGSYnBcp991t3VpISa9cX

from langchain_core.messages import AIMessage, ToolMessage

new_messages = [

# LLM API 도구 호출과 일치하는 ToolMessage 필요

ToolMessage(

content = modified_search_result,

tool_call_id=tool_call_id,

),

]

new_messages[-1].pretty_print()

Output:

================================= Tool Message =================================

[수정된 웹 검색 결과]

LangGraph는 상태 기반의 다중 액터 애플리케이션을 LLM을 활용해 구축할 수 있도록 지원합니다.

LangGraph는 사이클 흐름, 제어 가능성, 지속성, 클라우드 배포 기능을 제공하는 오픈 소스 라이브러리입니다.

자세한 튜토리얼은 [LangGraph 튜토리얼](https://langchain-ai.github.io/langgraph/tutorials/) 과

테디노트의 [랭체인 한국어 튜토리얼](https://wikidocs.net/233785) 을 참고하세요.

7.2.1 StateGraph의 update_state 메서드

update_state 메서드는 주어진 값으로 그래프의 상태를 업데이트합니다. 이 메서드는 마치 as_node에서 값이 온 것처럼 동작합니다.

매개변수는 다음과 같습니다.

config(RunnableConfig): 실행 구성values(Optional[Union[dict[str, Any], Any]]): 업데이트할 값들as_node(Optional[str]): 값의 출처로 간주할 노드 이름 기본 값은 None

반환값

- RunnableConfig

주요 기능

- 체크포인터를 통해 이전 상태를 로드하고 새로운 상태를 저장합니다.

- 서브그래프에 대한 상태 업데이트를 처리합니다.

as_node가 지정되지 않은 경우, 마지막으로 상태를 업데이트한 노드를 찾습니다.- 지정된 노드의 writer들을 실행하여 상태를 업데이트합니다.

- 업데이트된 상태를 체크포인트에 저장합니다.

주요 로직

- 체크포인터를 확인하고, 없으면 ValueError를 발생시킵니다.

- 서브그래프에 대한 업데이트인 경우, 해당 서브그래프의

update_state메서드를 호출합니다. - 이전 체크포인트를 로드하고, 필요한 경우

as_node를 결정합니다. - 지정된 노드의 writer들을 사용하여 상태를 업데이트합니다.

- 업데이트된 상태를 새로운 체크포인트로 저장합니다.

update_state 메서드 참고 사항

- 이 메서드는 그래프의 상태를 수동으로 업데이트 할 때 사용됩니다.

- 체크포인터를 사용하여 상태의 버전 관리와 지속성을 보장합니다.

as_node를 지정하지 않으면 자동으로 결정되지만, 모호한 경우 오류가 발생할 수 있습니다.- 상태 업데이트 중 SharedValues에 쓰기 작업은 허용되지 않습니다.

graph.update_state(

# 업데이트할 상태 지정

config,

# 제공할 업데이트된 값. 'State'의 메시지는 "추가 전용"으로 기존 상태에 추가됨

{"messages": new_messages},

as_node="tools",

)

print("(최근 1개의 메시지 출력)\n")

print(graph.get_state(config).values["messages"][-1])

Output:

(최근 1개의 메시지 출력)

content='[수정된 웹 검색 결과] \nLangGraph는 상태 기반의 다중 액터 애플리케이션을 LLM을 활용해 구축할 수 있도록 지원합니다.\nLangGraph는 사이클 흐름, 제어 가능성, 지속성, 클라우드 배포 기능을 제공하는 오픈 소스 라이브러리입니다.\n\n자세한 튜토리얼은 [LangGraph 튜토리얼](https://langchain-ai.github.io/langgraph/tutorials/) 과\n테디노트의 [랭체인 한국어 튜토리얼](https://wikidocs.net/233785) 을 참고하세요.' id='c8604646-cd73-40d8-8e98-2ebaf85fd5d5' tool_call_id='call_B0nxGSYnBcp991t3VpISa9cX'

최종 응답 메시지를 제공했기 때문에 그래프가 완성되었습니다. 상태 업데이트는 그래프 단계를 시뮬레이션하므로, 해당하는 traces도 생성합니다.

messages를 사전 정의된 add_messages 함수로 Annotated 처리했습니다. (이는 그래프에 기존 목록을 직접 덮어쓰지 않고 항상 값을 추가합니다.)

동일한 논리가 여기에도 적용되어, update_state에 전달된 메시지가 동일한 방식으로 메시지가 추가되게 됩니다.

update_state 함수는 마치 그래프의 노드 중 하나인 것처럼 작동합니다. 기본적으로 업데이트 작업은 마지막으로 실행된 노드를 사용하지만, 아래에서 수동으로 지정할 수 있습니다. 업데이트를 추가하고 그래프에 “chatbot”에서 온 것처럼 처리하도록 지시해 보도록 하겠습니다.

snapshot = graph.get_state(config)

events = graph.stream(None, config, stream_mode="values")

for event in events:

if "messages" in event:

event["messages"][-1].pretty_print()

Output:

================================= Tool Message =================================

[수정된 웹 검색 결과]

LangGraph는 상태 기반의 다중 액터 애플리케이션을 LLM을 활용해 구축할 수 있도록 지원합니다.

LangGraph는 사이클 흐름, 제어 가능성, 지속성, 클라우드 배포 기능을 제공하는 오픈 소스 라이브러리입니다.

자세한 튜토리얼은 [LangGraph 튜토리얼](https://langchain-ai.github.io/langgraph/tutorials/) 과

테디노트의 [랭체인 한국어 튜토리얼](https://wikidocs.net/233785) 을 참고하세요.

================================== Ai Message ==================================

LangGraph는 상태 기반의 다중 액터 애플리케이션을 대규모 언어 모델(LLM)을 활용하여 구축할 수 있도록 지원하는 오픈 소스 라이브러리입니다. 이 라이브러리는 사이클 흐름, 제어 가능성, 지속성 및 클라우드 배포 기능 등을 제공합니다.

자세한 튜토리얼은 [LangGraph 튜토리얼](https://langchain-ai.github.io/langgraph/tutorials/)과 [랭체인 한국어 튜토리얼](https://wikidocs.net/233785)을 참고하실 수 있습니다.

현재 상태를 이전과 같이 점검하여 체크포인트가 수동 업데이트를 반영하는지 확인합니다.

# 그래프 상태 스냅샷 생성

snapshot = graph.get_state(config)

# 최근 세 개의 메시지 출력

for message in snapshot.values["messages"]:

message.pretty_print()

Output:

================================ Human Message =================================

LangGraph가 무엇인지 조사하여 알려주세요!

================================== Ai Message ==================================

Tool Calls:

tavily_web_search (call_B0nxGSYnBcp991t3VpISa9cX)

Call ID: call_B0nxGSYnBcp991t3VpISa9cX

Args:

query: LangGraph

================================= Tool Message =================================

[수정된 웹 검색 결과]

LangGraph는 상태 기반의 다중 액터 애플리케이션을 LLM을 활용해 구축할 수 있도록 지원합니다.

LangGraph는 사이클 흐름, 제어 가능성, 지속성, 클라우드 배포 기능을 제공하는 오픈 소스 라이브러리입니다.